[Die Qualität der Rollendarstellung von Simulationspersonen im Clinical-Skills-Teil der Eidgenössischen Prüfung der Schweiz (EPCS) ist hoch und verbessert sich stetig, gemessen mit dem FAIR-OSCE-Instrument]

Kai P. Schnabel 1Daniel Bauer 1

Felix M. Schmitz 1

Tanja Hitzblech 1

Beate G. Brem 1

1 Universität Bern, Institut für Medizinische Ausbildung, Bern, Schweiz

Zusammenfassung

Einleitung: Simulationsbasierte Lehre und Prüfungen sind integraler Bestandteil der Ausbildung in den Gesundheitsberufen, wobei der Einsatz von Simulationspersonen (SP) eine weithin akzeptierte Strategie darstellt. Die Sicherstellung einer qualitativ hochwertigen SP-Rollendarstellung ist entscheidend für die Authentizität und Standardisierung von Prüfungen, insbesondere bei karriere-relevanten summativen Prüfungen wie der eidgenössischen Prüfung in Humanmedizin Clinical Skills (EPCS) der Schweiz.

Die Studie beurteilt die Qualität der SP-Rollendarstellung über mehrere aufeinanderfolgende EPCS. Wir stellten die Hypothese auf, dass sich die Qualität der Rollendarstellung mit der Zeit verbessert.

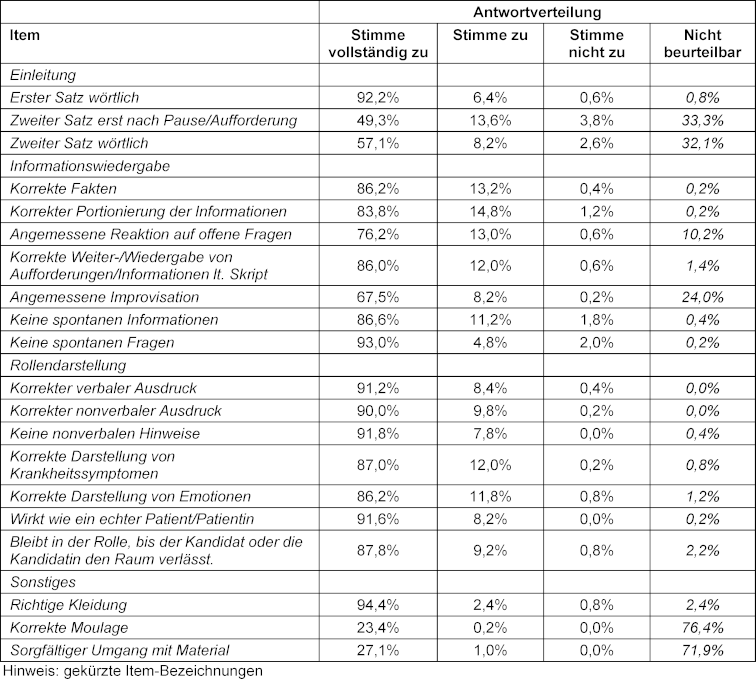

Methoden: In der Studie wurde das FAIR-OSCE-Instrument verwendet, um die SP-Rollendarstellung in fünf aufeinanderfolgenden EPCS von 2016 bis 2021 zu bewerten. Das Instrument, das zwischen 2011 und 2014 entwickelt wurde, umfasst vier Kategorien: Einführung, Informationsvermittlung, Rollendarstellung und weitere Elemente. Die Datenanalyse umfasste die retrospektive Überprüfung der FAIR-OSCE-Bewertungen, die Berechnung der Item-Scores und der durchschnittlichen Gesamtpunktzahl für jedes Prüfungsjahr.

Ergebnisse: An der Studie nahmen 37 SP-Expertinnen und Experten teil, die 1803 SP- Interaktionen mit Prüflingen an fünf Prüfungsstandorten beobachteten. Die Ergebnisse zeigten eine kontinuierliche Verbesserung der SP-Rollendarstellung über den Fünfjahreszeitraum, mit signifikanten Unterschieden zwischen 2016 und den Folgejahren. Die durchschnittlichen Gesamtwerte der SP-Rollenspielbewertungen stiegen stetig an, was auf einen positiven Trend in der SP-Leistung hindeutet.

Diskussion: Die Ergebnisse stützten die Hypothese einer kontinuierlichen Verbesserung der SP-Rollendarstellung innerhalb der EPCS. Die Qualität der Rollendarstellung verbesserte sich nicht nur durchweg, sondern hielt sich auch auf einem sehr hohen Niveau, wobei kein Item auf dem FAIR-OSCE-Instrument in mehr als 5% der Fälle mit „stimme nicht zu“ bewertet wurde. Dies deutet darauf hin, dass die SP-Rollendarstellungen gut mit den Fallskripten übereinstimmten, was die beabsichtigte Authentizität und Standardisierung der Bewertungen widerspiegelt.

Ein möglicher Bias bei der Bewertung der eigenen SP durch lokale SP-Experten und der ausschliessliche Fokus der Studie auf die Rollendarstellung von SP müssen hier einschränkend genannt werden. Während die Ergebnisse zum Verständnis der Effektivität von SP bei standardisierten, bestehensrelevanten klinisch-praktischen Prüfungen beitragen, wurden in der Studie andere potenzielle Varianzquellen nicht untersucht.

Schlussfolgerung: Zusammenfassend lässt sich sagen, dass die Studie über fünf Jahre hinweg eine kontinuierliche Verbesserung und die hohe Qualität der SP-Rollendarstellung in der EPCS zeigte. Gut ausgebildete SPs spielen, gemessen mit dem FAIR-OSCE-Instrument, eine entscheidende Rolle für die gleichbleibend hohe Qualität und Standardisierung bei karriereentscheidenden klinischen Kompetenzprüfungen. Weitere Forschung könnte zusätzliche Faktoren untersuchen, die die Gesamtqualität der Prüfungen beeinflussen, und potenzielle Bias bei den Bewertungen von SP-Expertinnen und -Experten untersuchen.

Schlüsselwörter

OSCE, objektive strukturierte klinische Prüfung, Standardisierung, standardisierter Patient, simulierter Patient, anspruchsvolle Prüfungen, Zulassungsprüfung, Patientensimulation

Einleitung

Simulationsbasierte Lehre und Prüfung sind für die Ausbildung und Prüfung von Gesundheitsberufen von entscheidender Bedeutung [1], [2]. Unter den verschiedenen simulationsbezogenen Optionen, wie dem Einsatz von Part-task Trainern, Full-Scale-Simulatoren und computergestützten Anwendungen, ist der Einsatz von Simulationspersonen (auch Simulationspatientinnen oder -patienten genannt, SP) eine bewährte Strategie in Simulationsszenarien [2], [3]. Erstmals in den 1960er Jahren eingeführt [4], [5] ist die Arbeit mit SPs in Lern- und Assessmentkontexten heutzutage von vielen medizinischen Fakultäten auf der ganzen Welt weithin akzeptiert und angewendet [6]. Objektive strukturierte klinische Prüfungen (OSCEs) [7] arbeiten regelmäßig mit SPs, in denen Medizinstudierende mit SP interagieren, die vordefinierte Patientenfälle darstellen, während die Leistungen der Studierenden bewertet werden. Die Qualität der Rollendarstellung der SPs ist von entscheidender Bedeutung, um faire und valide Prüfungen zu gewährleisten, vor allem im Hinblick auf Authentizität und Standardisierung [8]: Unzureichend authentische Rollendarstellung schränkt die Repräsentativität der den Prüflingen gestellten Aufgabe ein, unzureichend standardisierte Rollendarstellung schränkt die Vergleichbarkeit der Aufgaben und damit die Fairness in der Prüfungen ein, beides gefährdet die Validität der Prüfung [2], [9], [10]. Es ist die Aufgabe der SP-Expertinnen und Experten, dafür zu sorgen, dass die Rollendarstellung ein hohes Niveau und eine gute Balance zwischen Authentizität und Standardisierung aufweist [11], [12].

Die Schweiz hat 2011 die neue eidgenössische Prüfung Humanmedizin (EP) eingeführt [13], mit einem schriftlichen Teil und einem OSCE, den Absolventinnen und Absolventen der medizinischen Masterstudiengänge ablegen, um die Berufserlaubnis als Ärztinnen und Ärzte zu erlangen. Eine zunehmende Anzahl von Prüflingen (Absolventinnen und Absolventen des Medizinstudiums und Personen aus dem außereuropäischen Ausland, die eine Zulassung in der Schweiz anstreben) müssen in der EP bewertet werden, wobei im Jahr 2021 über tausend das Examen ablegten [14]. Es wurden verschiedene Maßnahmen ergriffen, um höchste Qualität bei der Entwicklung und Durchführung dieser Prüfung zu gewährleisten [15], [16], [17]. Die Qualität der gesamten EP spiegelt sich z. B. in Cronbachs Alpha von über 0,84 als Indikator für die Messzuverlässigkeit wider [17].

Um sicherzustellen, dass die SPs jedes einzelnen Szenarios mit ihren unterschiedlichen individuellen Hintergründen und Schauspielerfahrungen in homogenen Gruppen zusammengefasst werden, damit sie ihre jeweiligen Rollen über den gesamten Prüfungstag hinweg kontinuierlich gut darstellen, wurde ein Protokoll für die Schulung und Qualitätssicherung eingeführt. Dazu gehören 5 Tage Standardisierungstreffen auf Bundesebene, um ein gemeinsames Verständnis der Drehbücher und Szenarien und deren Umsetzung in die Praxis zu etablieren sowie Video-Material zu erstellen, das die prototypische Umsetzung jedes Szenarios darstellt (z. B. Standardisierung von Schmerzreaktionen, Auftragen von Moulagen [18], [19]). SP-Expertinnen und Experten sowie SPs der jeweiligen Prüfungsstandorte verwenden dieses Material dann pro Szenario in zwei Trainingseinheiten von jeweils 2 Stunden, um eine authentische und standardisierte Rollendarstellung während der Prüfung zu gewährleisten [17]. Während der Prüfung wird die Qualität der Rollendarstellung der SPs (und anderer Aspekte der Prüfung) durch Live-Beobachtung kontrolliert, z. B. über Einwegspiegel oder über Live-Stream in einen Kontrollraum.

Ein so komplexes wie ressourcenintensives Prüfungsformat wie das OSCE, welches sich sowohl auf Patientensicherheit auswirkt (Prüflinge, die mit falsch-positiven Ergebnissen bestehen) als auch auf die Karriere der Prüflinge (solche, die mit falsch-negativen Ergebnissen nicht bestehen) braucht notwendigerweise eine Analyse, ob die Darstellung der SP-Rollen in einem karriereentscheidenden OSCE gleichbleibend auf hohem Niveau durchgeführt wird. Das Ziel der vorliegenden Studie war es daher, die Qualität der Rollendarstellung von Simulationspersonen (SP) in klinischen High-Stakes-Prüfungen in der Schweiz über die Zeit zu bewerten. Wir stellten die Hypothese auf, dass sich die Qualität der SP-Rollendarstellung in der EPCS im Laufe der Zeit weiter verbessert.

Methodik

Um zu beurteilen, ob die SP-Rollendarstellung in High-Stakes-Prüfungen prinzipiell und über die Zeit auf hohem Niveau erfolgt, haben wir eine Kohortenstudie mit den fünf Schweizer SP-Programmen durchgeführt, die an der Durchführung mitverantworten.

Setting

Die EPCS wurde zum Zeitpunkt dieser Analyse an fünf Standorten (Basel, Bern, Genf, Lausanne und Zürich) gleichzeitig auf Französisch und Deutsch über drei Tage durchgeführt, wobei jeder Durchlauf 12 Stationen umfasste, fast alle mit Einsatz von SPs (umfassende Daten zur Prüfung sind in Anhang 1 [Anh. 1] verfügbar).

Verfahren

Um festzustellen, ob die SP-Rollendarstellung in der EPCS kontinuierlich auf hohem Niveau durchgeführt wird, wurde diese während der Durchführung der EPCS von 2016 bis 2021 analysiert, was fünf aufeinanderfolgenden Prüfungen entspricht, da die EPCS 2020 aufgrund der COVID-19-Pandemie nicht durchgeführt wurde. In diesen fünf Prüfungen wurde die klinische Kompetenz von über 5000 Prüflingen bewertet. Dabei wurden SPs eingesetzt, um insgesamt 70 parallele Durchläufe à 12 Stationen durchzuführen. Die Daten zur Rollendarstellung der SPs wurden an allen fünf Standorten während der fünf Prüfungen anhand zufälliger Beobachtungen live oder via Live-Stream unter Benutzung des FAIR-OSCE-Instruments gemessen. Die Raterinnen und Rater waren lokale SP-Expertinnen und Experten (1–5 pro Standort) und ein Beobachter mit bundesbehördlichem Mandat. Die SP-Expertinnen und Experten waren entweder Ärztinnen und Ärzte, erfahrene Gesundheitsexpertinnen und experten oder Schauspielerinnen und Schauspieler mit 2 bis 20 Jahren Erfahrung auf diesem Gebiet und Mitglieder des eidgenössischen SP-Trainerteams.

Instrument

Das FAIR-OSCE-Instrument wurde zwischen 2011 und 2014 von einem interfakultären Gremium Schweizer SP-Expertinnen und Experten entwickelt, um die Rollendarstellung von SP anhand beobachtbarer, fallunabhängiger Kriterien zu bewerten. Es basiert auf der einschlägigen Literatur und hat einen Konsensbildungsprozess im interfakultären Gremium durchlaufen, was seine Inhaltsvalidität belegt [15]. Das Instrument wurde zusätzlich in SP-Trainings sowie bei lokalen formativen und summativen OSCEs an der Fakultät Bern eingesetzt und hat damit seine Handhabbarkeit und Nützlichkeit bewiesen [15], [20].

Das Instrument umfasst vier Kategorien:

- Einführung (3 Items),

- Informationswiedergabe (7 Items),

- Rollendarstellung (7 Items) und

- Sonstiges (3 Items).

Die Items werden auf einer Skala mit den Punkten -1=stimme nicht zu, +1=stimme zu, +2=stimme vollständig zu und nicht zutreffend bewertet. (vgl. Anhang 2 [Anh. 2]).

Datenanalyse

Die FAIR-OSCE-Bewertungen von 2016 bis 2021 wurden retrospektiv analysiert. Die Item-Scores wurden berechnet, um die Qualität der SP-Rollendarstellung innerhalb der Prüfung eines jeden Jahres hervorzuheben und es wurden die Mittelwerte für jede der fünf Prüfungen berechnet (2016 bis 2021, die als „nicht zutreffend“ bewerteten Items wurden ausgeschlossen), d. h. alle Beurteilungen basieren auf Daten aller Standorte, an denen die Prüfung im jeweiligen Jahr durchgeführt wurde.

Statistische Unterschiede zwischen den Jahren wurden mit einer einfaktoriellen ANOVA berechnet. Die Effektstärken wurden mit Eta-Quadrat berechnet, wobei η2~0,01 für kleine, η2~0,06 für mittlere und η2>=0,14 für grosse Effekte gilt. Post-hoc-Analysen wurden mit Bonferroni-Tests für jeden möglichen Gruppenvergleich berechnet.

Ethische Nichtbedenklichkeit

Eine Beurteilung dieser Studie durch die zuständige Ethikkommission war gemäss Schweizer Gesetzgebung (Kapitel 1, Artikel 2 des Schweizer Humanforschungsgesetzes von 2011) nicht erforderlich. Die ethischen Grundsätze gemäss der WMA-Deklaration von Helsinki und der guten wissenschaftlichen Praxis wurden durchgehend eingehalten.

Ergebnisse

Während der fünf EPCS zwischen 2016 und 2021 beobachteten insgesamt N=37 verschiedene SP-Expertinnen und Experten (ca. 2–4 pro Standort und Jahr, meist dieselben SP-Expertinnen und Experten im Laufe der Jahre) insgesamt N=1803 Interaktionen zwischen SPs und Prüflingen (Basel n=247, Bern n=419, Genf n=357, Lausanne n=467 und Zürich n=313) und bewerteten die SP-Rollendarstellung.

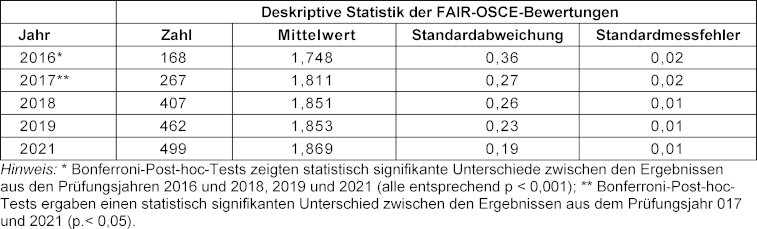

Die Anzahl der Beobachtungen stieg von anfänglich 168 Beobachtungen im Jahr 2016 auf maximal 499 Beobachtungen im Jahr 2021 (siehe Tabelle 1 [Tab. 1]).

Tabelle 1: FAIR-OSCE-Antwortverteilung, exemplarisch aus der Prüfung 2021

Die Mittelwerte der SP-Rollenspiel-Bewertungen stiegen über die Jahre kontinuierlich an (siehe Tabelle 2 [Tab. 2]). Die ANOVA zeigte, dass mindestens ein Anstieg über die Jahre hinweg von statistischer Signifikanz war (F=9,2, p<0,001; η2=0,02). Die entsprechenden Bonferroni-Post-hoc-Tests zeigten, dass die Ergebnisse von 2018 bis 2021 im Vergleich zu 2016 signifikant besser ausfielen (vgl. Tabelle 2 [Tab. 2]).

Tabelle 2: Deskriptive Statistiken zu den FAIR-OSCE-Bewertungen pro Prüfungsjahr

Diskussion

In Bezug auf unsere Hypothese konnten wir zeigen, dass die Qualität der SP-Rollendarstellung über die analysierten fünf Jahre kontinuierlich zunahm, signifikant war dies beim Vergleich der Daten aus 2021 mit 2016 und 2017, 2018 und 2017 mit 2016.

Damit konnten wir die anfängliche Hypothese von steigender Qualität bestätigen.

Die Qualität der Rollendarstellung verbesserte sich nicht nur kontinuierlich, sondern befand sich auch auf einem sehr hohen Niveau, wobei keine Items auf dem FAIR-OSCE-Instrument häufiger als in 5% der zufälligen Beobachtungen in allen vier Kategorien mit „stimme nicht zu“ bewertet wurden, was bedeutet, dass die Rollendarstellungen skriptkonform umgesetzt wurden. Beide Ergebnisse können als Indikatoren dafür gewertet werden, dass sowohl die Prüfung als auch die eingesetzten SPs von höchster Qualität sind. Das ist auch ein Indikator dafür, dass das FAIR-OSCE-Instrument in der Lage ist, die steigende Qualität der Prüfung zu messen, obwohl die Messung bereits auf einem sehr hohen Niveau begonnen hat, wenn man den Startpunkt der EP im Jahr 2011 berücksichtigt (wo man die steilste Lernkurve erwarten würde), was das Argument der Reliabilität des Instruments untermauert.

Die Ergebnisse sind im Übrigen kein Maß für die Gesamtqualität der EPCS, sondern lediglich ein Mosaikstein, da andere potenzielle Varianzquellen, wie die Prüferinnen und Prüfer, Checklisten und weitere kontextuelle Faktoren nicht untersucht wurden und über den Rahmen dieser Studie hinausgehen würden. Eine mögliche Quelle für einen Bias in der vorliegenden Studie liegt in der Art und Weise, wie lokale SP-Expertinnen und Experten die Qualität der Rollendarstellung ihrer SPs bewerteten, die von ihnen selbst oder ihrem Team trainiert wurden. Dies stellt jedoch einen systematischen Fehler dar, der für alle Standorte gelten würde. Das Inter-Rater-Übereinstimmung bei der Nutzung des FAIR-OSCE wurde bisher nicht untersucht und war auch nicht hat Gegenstand dieser Studie, sollte aber in zukünftigen Arbeiten untersucht werden. Eine parallele Bewertung mit den Authentizitäts-Items des MaSP [21] könnte die Validität von FAIR OSCE weiter untermauern. Die vorliegende Studie wurde zwar nur in einem Land und im Rahmen einer Prüfung durchgeführt, doch die Tatsache, dass sie im Rahmen einer hoch standardisierten, staatlichen Zulassungsprüfung an fünf Standorten in zwei Sprachen durchgeführt wurde, verleiht ihr einen gewissen Wert.

Schlussfolgerung

Es zeigte sich, dass die Rollendarstellung der SPs in einer Reihe hochstandardisierter, karriereentscheidender Prüfungen von höchster Qualität war und in allen analysierten Prüfungskohorten sogar zunahm. Gut ausgebildete SPs, die mit einem geeigneten Instrument beobachtet werden, tragen somit zu einer standardisierten, qualitativ hochwertigen klinischen Kompetenzprüfung bei.

ORCIDs der Autorinnen und Autoren

- Kai P. Schnabel: [0000-0002-6977-2717]

- Daniel Bauer: [0000-0002-3337-3327]

- Tanja Hitzblech: [0000-0003-0876-0373]

- Beate G. Brem: [0000-0002-0551-9587]

Danksagung

Die Autorinnen und Autoren bedanken sich herzlich bei allen SP-Expertinnen und Experten, die das Instrument anwenden und die Daten während der Prüfungen zusammengetragen haben, die als Grundlage für die Analysen dienten.

Interessenkonflikt

Die Autorinnen und Autoren erklären, dass sie keinen Interessenkonflikt im Zusammenhang mit diesem Artikel haben.

Literatur

[1] Bradley P. The history of simulation in medical education and possible future directions. Med Educ. 2006;40(3):254-62. DOI: 10.1111/j.1365-2929.2006.02394.x[2] Bauer D, Lahner FM, Huwendiek S, Schmitz FM, Guttormsen S. An overview of and approach to selecting appropriate patient representations in teaching and summative assessment in medical education. Swiss Med Wkly. 2020;150:w20382. DOI: 10.4414/smw.2020.20382

[3] Nestel D, Kneebone R. Perspective: authentic patient perspectives in simulations for procedural and surgical skills. Acad Med. 2010;85(5):889-893. DOI: 10.1097/ACM.0b013e3181d749ac

[4] Barrows HS, Abrahamson S. The Programmed Patient: A Technique for Appraising Student Performance in Clinical Neurology. J Med Educ. 1964;39:802-5.

[5] Barrows HS. Simulated patients in medical teaching. Can Med Assoc J. 1968;98(14):674-676.

[6] Nestel D, Bearman M. Simulated Patient Methodology. Malden (MA); Oxford (UK): West Sussex UK: John Wiley & Sons Ltd.; 2015. DOI: 10.1002/9781118760673

[7] Harden RM, Stevenson M, Downie WW, Wilson GM. Assessment of clinical competence using objective structured examination. Br Med J. 1975;1(5955):447-451. DOI: 10.1136/bmj.1.5955.447

[8] Smith CM, Gliva-Mcconvey G, Chapin A. Training SPs for Authentic Role Portrayal. In: Gliva-McConvey G, Nicholas CF, Clark L, editors. Comprehensive Healthcare Simulation: Implementing Best Practices in Standardized Patient Methodology Comprehensive Healthcare Simulation. Cham: Springer; 2020. DOI: 10.1007/978-3-030-43826-5

[9] Haladyna TM, Downing SM. Construct-Irrelevant Variance in High-Stakes Testing. Educ Measurement. 2004;23(1):17-27. DOI: 10.1111/j.1745-3992.2004.tb00149.x

[10] Smith CM, O`Byrne CO, Nestel D. Simulated patient methodology and assessment. In: Nestel D, Bearman M, editors. Simulated Patient Methodology. Malden (MA); Oxford (UK): West Sussex UK: John Wiley & Sons Ltd.; 2015. p.85-92. DOI: 10.1002/9781118760673.ch12

[11] Lewis KL, Bohnert CA, Gammon WL, Hölzer H, Lyman L, Smith C, Thompson TM, Wallace A, Gliva-Mcconvey G. The Association of Standardized Patient Educators (ASPE) Standards of Best Practice (SOBP). Adv Simul (Lond). 2017;2:10. DOI: 10.1186/s41077-017-0043-4

[12] Brem B, Steinweg B. Prüfungen mit SPs. In: Peters T, Thrien C, editor. Simulationspatienten Handbuch für die Aus- und Weiterbildung in medizinischen und Gesundheitsberufen. 1. Auflage. Göttingen: Hogrefe Verlag; 2018.

[13] Guttormsen S, Beyeler C, Bonvin R, Feller S, Schirlo C, Schnabel K, Schurter T, Berendonk C. The new licencing examination for human medicine: from concept to implementation. Swiss Med Wkly. 2013;143:w13897. DOI: 10.4414/smw.2013.13897

[14] Bundesamt für Gesundheit. Statistiken Ärztinnen/Ärzte. Bern: Bundesamt für Gesundheit; 2022. Zugänglich unter/available from: https://www.bag.admin.ch/dam/bag/de/dokumente/berufe-gesundheitswesen/medizinalberufe/statistiken/med/aerztinnen-aerzte-2021.pdf.download.pdf/Aerztinnen_und_Aerzte_2021_DE.pdf

[15] Brem B, Richter S, Schnabel KP. FAIR_OSCE - Feedbackstructure for assessment of interactive roleplay in Objective Structured Clinical Exams. In: 4th Swiss Conference on Standardized Patients and Simulation in Health Care. Bern, 10-12 September 2014. SC2-5. Zugänglich unter/available from: https://with-simulation.ch/programm-2014/

[16] Bachmann C, Kropf R, Biller S, Schnabel KP, Junod Perron N, Monti M, Berendonk C, Huwendiek S, Breckwoldt J. Development and national consensus finding on patient-centred high stakes communication skills assessments for the Swiss Federal Licensing Examination in Medicine. Patient Educ Couns. 2021;104(7):1765-1772. DOI: 10.1016/j.pec.2020.12.003

[17] Berendonk C, Schirlo C, Balestra G, Bonvin R, Feller S, Huber P, Junger E, Monti M, Schnabel K, Beyeler C, Guttormsen S, Huwendiek S. The new final Clinical Skills examination in human medicine in Switzerland: Essential steps of exam development, implementation and evaluation, and central insights from the perspective of the national Working Group. GMS Z Med Ausbild. 2015;32(4):Doc40. DOI: 10.3205/zma000982

[18] Schnabel KP, Lorwald AC, Beltraminelli H, Germano M, Brem BG, Wust S, Bauer D. Development and evaluation of three-dimensional transfers to depict skin conditions in simulation-based education. GMS J Med Educ. 2024;41(2):Doc14. DOI: 10.3205/zma001669

[19] Bauer D, Lorwald AC, Wust S, Beltraminelli H, Germano M, Michel A, Schnabel KP. Development, production and evaluation of 2-dimensional transfer tattoos to simulate skin conditions in health professions education. BMC Med Educ. 2021;21(1):350. DOI: 10.1186/s12909-021-02763-z

[20] Brem BG, Richter S, Schnabel KP. Quality Control for SP Performance Regarding Patient Portrayal in a High-Stakes OSCE. In: Association of Standardised Participants Educators (ASPE) annunal Conference; June 22rd – 25th, 2014; Indianapolis (IN); 2014. p.F-P24.

[21] Wind LA, Van Dalen J, Muijtjens AM, Rethans JJ. Assessing simulated patients in an educational setting: the MaSP (Maastricht Assessment of Simulated Patients). Med Educ. 2004;38(1):39-44. DOI: 10.1111/j.1365-2923.2004.01686.x