[Multisource-Feedback in der ärztlichen Weiterbildung: Eine quantitative Studie zur Untersuchung des Feedbackgesprächs]

Eva K. Hennel 1,2Felicitas-M. Lahner 1,3

Noemi Zweifel 4

Sigrid Harendza 5

Kathrin Neuhaus 4

Sören Huwendiek 1

1 Universität Bern, Institut für Medizinische Lehre, Abteilung für Assessment und Evaluation (AAE), Bern, Schweiz

2 Schweizerisches Institut für ärztliche Weiter- und Fortbildung SIWF, Bern, Schweiz

3 Berner Fachhochschule, Departement Gesundheit, Bern, Schweiz

4 Universitätskinderspital Zürich, Chirurgische Klinik, Zürich, Schweiz

5 Universitätsklinikum Hamburg-Eppendorf, III. Medizinische Klinik, Hamburg, Deutschland

Zusammenfassung

Einleitung: Multisource Feedback (MSF) ist ein Bewertungsformat in der medizinischen Aus- und Weiterbildung. Es liefert individuelles Feedback auf Grundlage mehrerer Bewertungen, das dann in einem Feedbackgespräch zwischen der Supervisionsperson und der Person in Weiterbildung zur Entwicklung von Lernzielen verwendet werden kann. Wir haben diese Studie durchgeführt, um zu untersuchen, wie Weiterzubildende und Supervisionspersonen die Lernziele festlegen und worauf sich diese Lernziele beziehen.

Methoden: Die Studie umfasste 75 MSF-Datensätze, die pro Person in Weiterbildung aus 12 bis 15 externen Bewertungen und einer Selbstbewertung bestanden. Die Daten umfassten insgesamt 1015 externe Bewertungen und 75 Selbstbewertungen. Da zehn Datensätze keine Lernziele enthielten, konnten nur 65 MSF-Datensätze analysiert werden. Die Datensätze enthielten schriftliches MSF-Feedback, einschliesslich skalenbasierter Bewertungen und narrativer Kommentare sowie strukturierte Protokolle der Feedbackgespräche mit den daraus resultierenden Lernzielen, die nach Themen sortiert wurden. Wir verwendeten multiple lineare Regressionen, um die Zusammenhänge zwischen Feedbackdaten, Gesprächsthemen und Lernzielen zu ermitteln.

Ergebnisse: Themen wurden in den Feedbackgesprächen eher als Stärken diskutiert, wenn die skalenbasierten Bewertungen hoch waren und es viele positive Kommentare zu einem Item gab. Themen wurden eher als Bereiche zur Verbesserung diskutiert, wenn die Anzahl der negativen Kommentare hoch war. Themen mit vielen (positiven und negativen) Kommentaren und Themen, die als verbesserungswürdig diskutiert wurden, führten eher zu Lernzielen. Wir fanden eine Reihe von Lernzielen, die über die Kompetenzen des MSF-Fragebogens hinausgehen und im Zusammenhang mit der Entwicklung der professionellen Identität gesehen werden können.

Fazit: Da das Feedback und die Lernziele über die im MSF-Fragebogen aufgelisteten Kompetenzen hinausgingen, scheint es uns notwendig, diese umfassenderen Themen, die die Entwicklung der Weiterzubildenden betreffen, anzusprechen. Daher empfehlen wir Supervisionspersonen und Weiterzubildenden, Aspekte der Entwicklung der professionellen Identität wie Karrierepläne, Engagement in der Forschung oder persönliche Haltungen ausdrücklich in regelmässige Bewertungen und Feedbackgespräche einzubeziehen. Auf diese Weise könnte MSF ein geeignetes Instrument sein, um die Entwicklung der professionellen Identität zu unterstützen.

Schlüsselwörter

Entwicklung der professionellen Identität, formatives Prüfen, Multisource Feedback, ärztliche Weiterbildung, arbeitsplatzbasiertes Assessment

1. Einleitung

Multisource Feedback (MSF) oder 360° Feedback wird verwendet, um die medizinische Aus- und Weiterbildung zu unterstützen, insbesondere die Entwicklung von Fähigkeiten und Kompetenzen [1], [2], [3], [4] . In diesem Artikel stellen wir dar, wie MSF auch die Entwicklung der professionellen Identität unterstützen kann, wie sie von Jarvis-Selinger beschrieben ist [5]. Im Gegensatz zu anderen arbeitsplatzbasierten Bewertungen umfasst MSF mehrere Perspektiven auf die Leistung einer Person in Weiterbildung in verschiedenen Situationen und über einen längeren Zeitraum. Häufig fasst beim MSF eine Supervisionsperson das Feedback zusammen und „übermittelt” es der Person in Weiterbildung, einschliesslich aller skalenbasierter Bewertungen und schriftlicher Kommentare. Während dieses Feedbackgesprächs wird das Feedback mit der Selbsteinschätzung der Person in Weiterbildung verglichen und Lernziele definiert, um die Person in Weiterbildung individuell zu begleiten.

Die meisten Studien zu MSF konzentrierten sich auf Feedback , das an Fach- und Oberärzt*innen gegeben wird und untersuchten Faktoren, die die Wirksamkeit und die Ergebnisse von MSF beeinflussen [6], [7], [8], [9], [10], [11]. Obgleich es Empfehlungen gibt, wie in Feedbackgesprächen die emotionalen Reaktionen gesteuert [11] und die Reflexion gefördert werden können [9], haben nur wenige Studien Faktoren in den realen Umgebungen untersucht, in denen diese Gespräche tatsächlich stattfanden [6], [7], [9], [11]. Einige Studien begründeten die Notwendigkeit von Feedbackgesprächen eher mit den Erwartungen von Teilnehmenden als mit ihren Erfahrungen [8], [10], [12]. Keine Studie analysierte den Inhalt oder den Ablauf dieser Gespräche oder beobachtete die Interaktion zwischen Supervidierenden und Weiterzubildenden. Daher ist unbekannt, wie Supervisionspersonen die MSF-Bewertungen filtern und zusammenfassen oder diese zur Erstellung von Lernzielen verwenden. In nicht-medizinischen Bereichen, in denen Feedback schriftlich ohne Gespräch gegeben wurde, wurden die Lernziele durch die Anzahl der narrativen Kommentare, die Polarität der Kommentare (positiv oder negativ) und den Fokus der Kommentare (aufgabenorientiert versus eigenschaftsorientiert) geprägt [13].

Um zu verstehen, wie Lernziele in der Weiterbildung festgelegt werden und worauf sie sich beziehen, sind bessere Kenntnisse über den Inhalt der Feedbackgespräche zwischen der Supervisionsperson und der Person in Weiterbildung erforderlich. In dieser Studie untersuchen wir, wie MSF-Bewertungen die Feedbackgespräche beeinflusst haben und wie beide, die Bewertungen und die Gespräche, die Anzahl und den Inhalt der Lernziele der Weiterzubildenden geprägt haben. Unser Ziel ist es, die Schulung von Supervisionspersonen und Weiterzubildenden anhand dieser Erkenntnisse zu verbessern, um den gezielten Einsatz von MSF zu ermöglichen.

2. Methoden

2.1. Ethik

Die lokale Ethikkommission der Schweizerischen Vereinigung der Forschungsethikkommissionen beurteilte die Studie als nicht bewilligungspflichtig. Alle Teilnehmenden gaben ihre schriftliche Einwilligung zur Teilnahme und zur Veröffentlichung ihrer anonymisierten Daten.

2.2. Setting

Die Studie wurde an der Abteilung für Chirurgie des Universitätskinderspitals Zürich, Schweiz, durchgeführt. MSF wird dort als obligatorischer Bestandteil der fachärztlichen Ausbildung mit formativem Zweck eingesetzt und wurde 2015 auf der Grundlage von Best-Practice-Literatur [6], [7], [9], [14], [15], [16], [17], [18], [19], [20] eingeführt. Alle Teilnehmenden (Weiterzubildende, Bewertende und Supervisionspersonen) wurden über die Ziele, Inhalte und den MSF-Fragebogen einschliesslich der Bewertungsskala und der Feedbackregeln informiert. Die Supervisionspersonen lernten, spezifisches Feedback zu geben und dabei die Anonymität der Bewertenden zu wahren. Der MSF-Fragebogen basierte auf den Can-MEDS-Rollen [21] und wurde bereits ausführlich beschrieben [22].

Der MSF-Prozess in dieser Studie umfasste bis zu 15 externe Bewertende aus vordefinierten Gruppen von Mitarbeitenden, die zweimal jährlich Feedbacks gaben. Die Bewertenden füllten den MSF-Fragebogen online aus, ihr Feedback wurde später anonymisiert und zusammengefasst verwendet. Während des Feedbackgesprächs teilte die Supervisionsperson den Mittelwert der skalenbasierten Bewertungen mit und fasste narrative Kommentare zusammen, die ihr wichtig erschienen. Die Supervisionspersonen und die Weiterzubildenden entschieden jeweils gemeinsam, welche Items des MSF-Fragebogens besprochen werden sollten, legten die Themen für das Feedbackgespräch fest und bestimmten die Anzahl und den Inhalt der Lernziele. Sie dokumentierten die MSF-Bewertungen, Stärken oder Bereiche der Verbesserung, sowie die Lernziele in einem strukturierten Formular.

2.3. Studiendesign und Datenerhebung

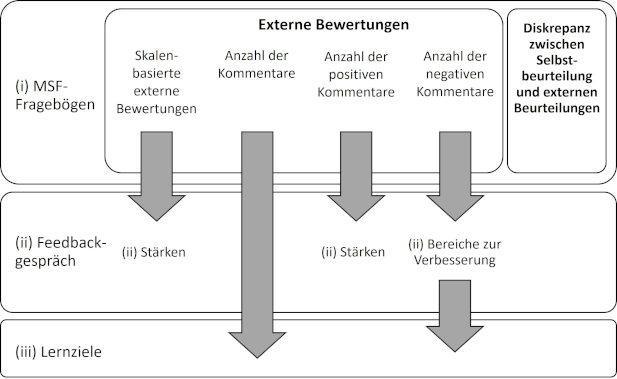

Entsprechend der einleitend beschriebenen spezifischen Literaturlücke zum Feedbackgespräch haben wir uns bewusst für ein quantitatives Studiendesign entschieden. Um den Weg der Daten während des Gesprächs so genau wie möglich nachzuvollziehen, haben wir das Gespräch in drei kleinere Teile aufgetrennt, die jeweils dokumentierte, quantifizierbare Daten enthalten.

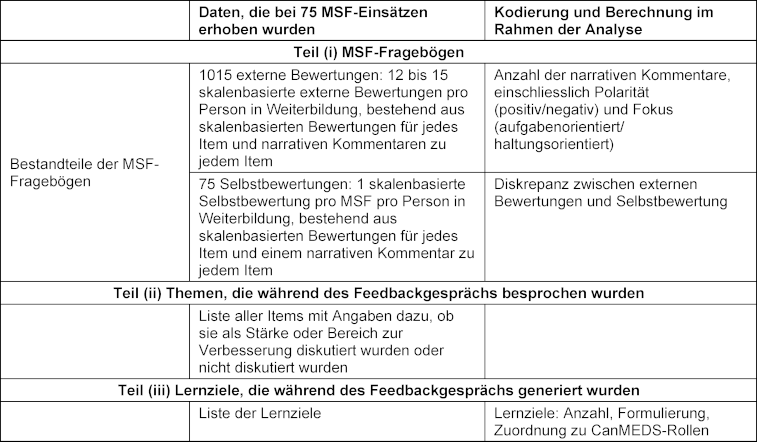

Die Studie umfasste 75 MSF-Datensätze, die pro Person in Weiterbildung aus 12-15 externen Bewertungen und einer Selbstbewertung bestanden. Die Daten umfassten insgesamt 1015 externe Bewertungen und 75 Selbstbewertungen. Da in zehn Datensätzen die Lernziele fehlten, konnten nur 65 MSF-Datensätze analysiert werden. Detailliertere Informationen und eine Übersicht über die drei Teile des Feedbackgesprächs sind in Tabelle 1 [Tab. 1] dargestellt.

Tabelle 1: Datenerhebung und -analysen entsprechend der drei in dieser Studie untersuchten Teile vom MSF

2.4. Definition und Berechnung von narrativen Kommentaren, Lernzielen und Einflussfaktoren

Die Datenkodierung orientierte sich an [13] und [23].

2.4.1. Polarität der narrativen Kommentare

Narrative Kommentare, die eindeutig lobend oder bestätigend waren, wurden als „positiv“ kodiert. Korrekturen und kritische Kommentare, einschliesslich solcher in kritischem Ton („manchmal zu motiviert“, „nicht sicher, ob das Wissen ausreicht“), wurden als „negativ“ kodiert. Kommentare, die nicht eindeutig zugeordnet werden konnten, wurden als „nicht zuzuordnen“ kodiert.

2.4.2. Qualität der narrativen Kommentare

Narrative Kommentare wurden ausserdem als aufgabenorientiert oder eigenschaftsorientiert kodiert. Kommentare, die eindeutig beschrieben, wie eine bestimmte Aufgabe durchgeführt wurde oder durchgeführt werden sollte, wurden als „aufgabenorientiert“ kodiert. Kommentare, die sich direkt auf die Person oder ihre Haltungen bezogen, wurden als „eigenschaftsorientiert“ kodiert. Kommentare, die nicht eindeutig zugeordnet werden konnten, wurden als „nicht zuzuordnen “ kodiert.

2.4.3. Anzahl der Lernziele

Wir haben die Lernziele anhand ihres Inhalts definiert und gezählt. Wir hatten Zugang zu 75 Protokollen von Feedbackgesprächen, haben jedoch 13 davon aus der Analyse der Lernziele ausgeschlossen, da sie keine Notizen zu Lernzielen enthielten (diese Weiterzubildenden befanden sich am Ende ihrer Ausbildung auf der Abteilung). Die Notizen aus zwei weiteren Gesprächen waren verloren, sodass unser Datensatz den Text von 60 der 75 Protokolle umfasste.

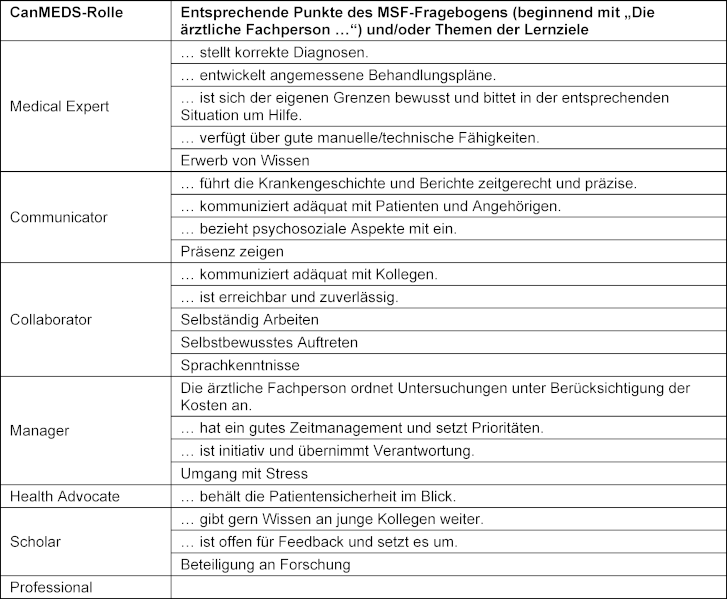

2.4.4. Inhalt der Lernziele

Wir überprüften, ob jedes dokumentierte Lernziel sich einem oder mehreren Items des MSF-Fragebogens zuordnen lässt. Ziele, die mit mehr als einem Item verbunden waren (z. B. „Erwerb von Wissen“) oder Ziele, die keinen Bezug zum MSF-Fragebogen zu haben schienen, wurden qualitativ analysiert und separat gezählt. Anschliessend haben wir alle Lernziele den CanMEDS-Rollen zugeordnet (siehe Tabelle 2 [Tab. 2]).

Tabelle 2: Annahmen für multiple lineare Regressionen

2.4.5. Einflussfaktoren

Wir haben Einflussfaktoren auf der Grundlage von 1015 skalenbasierten externen Bewertungen und 75 skalenbasierten Selbstbewertungen berechnet. Alle 16 Items des MSF-Fragebogens wurden auf einer 5-Punkte-Skala bewertet, von „unter meinen Erwartungen“ (1) bis „weit über meinen Erwartungen“ (5) oder alternativ mit „keine Angabe“ mit Platz für narrative Kommentare direkt nach jedem Punkt.

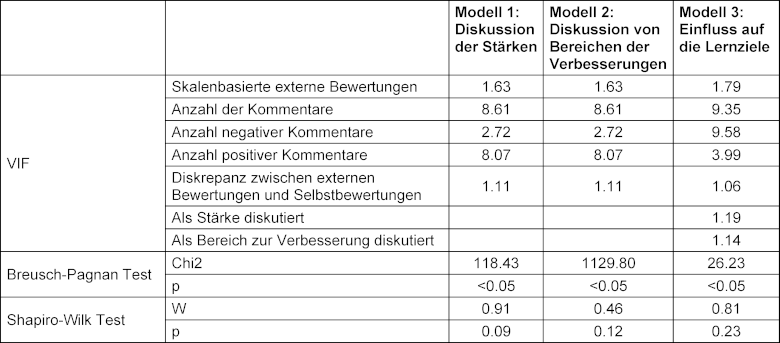

2.5. Regressionsanalysen

Wir verwendeten multiple lineare Regressionen, um den Einfluss der skalenbasierten externen Bewertungen, der Anzahl der Kommentare, der Anzahl der positiven Kommentare, der Anzahl der negativen Kommentare und der Diskrepanz zwischen externen Bewertungen und Selbstbewertungen zu ermitteln. Um zu überprüfen, ob die Annahmen für multiple lineare Regressionen erfüllt waren, verwendeten wir den Breusch-Pagan-Test zur Analyse der Homoskedastizität, den VIF-Wert zur Analyse der Multikollinearität und den Shapiro-Wilk-Test zur Prüfung der Normalverteilung der Residuen. Da alle drei Modelle einen signifikanten Breusch-Pagan-Test auf Heteroskedazität zeigten, haben wir heteroskedazitätskonsistente Standardfehler verwendet. In allen drei Modellen lagen die VIF-Werte unter 10, was auf keine Multikollinearität hindeutet. Nach dem Shapiro-Wilk-Test waren die Residuen normalverteilt. Die Ergebnisse der statistischen Analyse sind in Tabelle 2 [Tab. 2] zu finden.

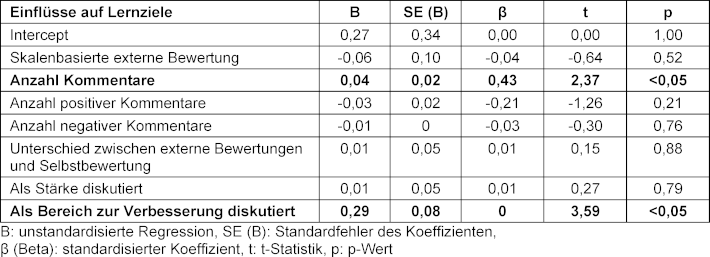

Wir haben das unstandardisierte Beta (Β), den Standardfehler für das unstandardisierte Beta (SE(Β)), das standardisierte Beta (β), die t-Teststatistik (t) und den Wahrscheinlichkeitswert (p) dargestellt. Die Regressionsanalysen untersuchten zunächst den Einfluss dieser Variablen auf die Diskussion der Stärken, dann auf die Diskussion der Bereiche zur Verbesserung und schliesslich auf die während des Feedbackgesprächs festgelegten Lernziele. Als Index für die Effektgrösse wurde R2 verwendet. Das Signifikanzniveau wurde auf p<0,05 festgelegt. Alle Analysen wurden mit R (Version 3.2.0) [24] durchgeführt.

3. Ergebnisse

3.1. Narrative Kommentare

Die MSF-Datensätze umfassten 3024 narrative Kommentare, durchschnittlich 2,63 Kommentare pro Item pro Person in Weiterbildung (zwischen 0 und 12, SD=1,90) und insgesamt 39,51 Kommentare pro Person in Weiterbildung (zwischen 15 und 66, SD=12,09). Von den narrativen Kommentaren waren 77% positiv, 15% negativ und 7% konnten nicht zugeordnet werden; 95% der narrativen Kommentare waren aufgabenorientiert, 0,9% eigenschaftsorientiert und 3,5% konnten nicht zugeordnet werden.

3.2. Lernziele

3.2.1. Anzahl der Lernziele

Insgesamt haben wir 132 separate Lernziele analysiert, was einem Durchschnitt von 2,13 (zwischen 0 und 4) Lernzielen pro Person in Weiterbildung und Feedbackgespräch entspricht.

3.2.2. Inhalt der Lernziele

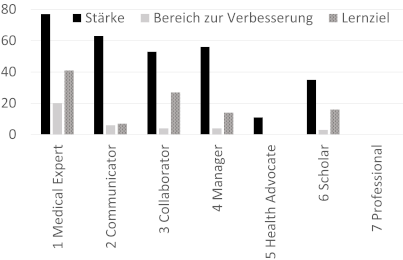

Von diesen 132 Zielen konnten 68 direkt einzelnen Items des MSF-Fragebogens zugeordnet werden, 64 entsprachen mehreren Items oder bezogen sich auf Themen, die im MSF-Fragebogen nicht erwähnt wurden. Diese 64 Ziele wiesen im Vergleich zu den kompetenzbasierten Items des Fragebogens eine andere Qualität auf und bezogen sich auf weiter gefasste Konzepte, die mit Bezug auf die Entwicklung der professionellen Identität verstanden werden können. Sie betrafen die Karriereplanung (n=24), den Erwerb von Wissen (n=15), wissenschaftliches Arbeiten (n=9), selbstbewusstes Auftreten (n=7), selbstständiges Arbeiten (n=3) und andere Themen (z. B. Sprachkenntnisse, Präsenz zeigen, Umgang mit Stress; n=6). Um möglichst viele Ziele in die Berechnungen einbeziehen zu können, haben wir sie, mit Ausnahme von drei übergeordneten Zielen und 24 Zielen zur Karriereplanung, den entsprechenden CanMEDS-Rollen zugeordnet, siehe Tabelle 3 [Tab. 3] und Abbildung 1 [Abb. 1].

Tabelle 3: Zuordnung der Items des MSF-Fragebogens und der Lernziele zu den CanMEDS-Rollen. Die CanMEDS-Rollen wurden bewusst nicht ins Deutsche übersetzt

Drei Ziele, die sich auf die Gesamtleistung bezogen, und 24 Ziele, die sich auf die Karriereplanung bezogen, wurden nicht zugeordnet und nicht in die Berechnungen einbezogen.

Abbildung 1: Inhalt der Gespräche und Lernziele, dokumentiert auf dem strukturierten Formular für das Feedbackgespräch, abhängig von den CanMEDS-Rollen. Die CanMEDS-Rollen wurden bewusst nicht ins Deutsche übersetzt.

Hinweis: Diese Grafik enthält nicht die 3 Ziele, die sich auf die Gesamtleistung konzentrierten und nicht die 24 Ziele zur Karriereplanung.

3.3. Einflussfaktoren

Unsere Ergebnisse sind in Abbildung 2 [Abb. 2] zusammengefasst.

Abbildung 2: Überblick über Faktoren, die das Feedbackgespräch und die Lernziele beeinflussen

Pfeile stehen für einen signifikanten Einfluss.

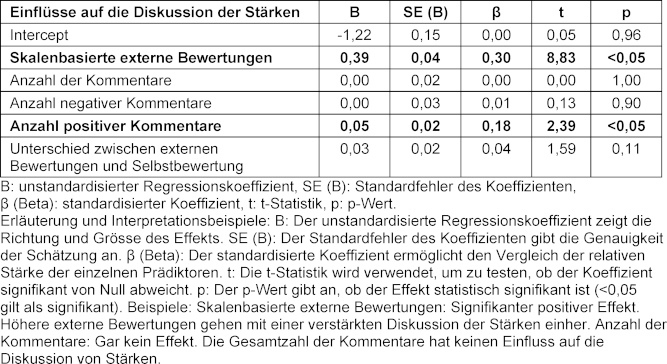

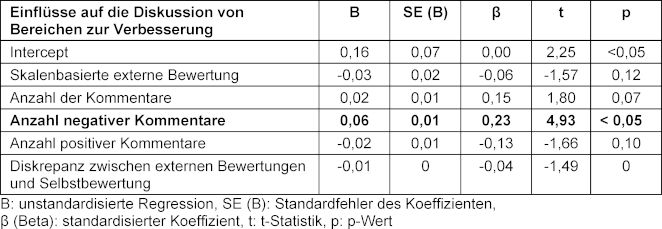

Bei der Analyse der Einflussfaktoren fanden wir signifikante Regressionsgleichungen (F(5/1116)=48,3, p<0,05) mit einem R2 von 0,17 für Themen, die als Stärken diskutiert wurden (F(5/1116)=27,5, p<0,05), einem R2 von 0,11 für Themen, die als Bereiche der Verbesserung diskutiert wurden (F(7/352)=7,8, p<0,05), und einem R2 von 0,11 für Lernziele, siehe Tabelle 3 [Tab. 3], Tabelle 4 [Tab. 4] und Tabelle 5 [Tab. 5] für die Regressionskoeffizienten.

Tabelle 4: Einflüsse auf die Diskussion der Stärken

Tabelle 5: Einflüsse auf die Diskussion von Bereichen zur Verbesserung

3.3.1. Anzahl der aufgabenorientierten oder eigenschaftsorientierten Kommentare

Von den narrativen Kommentaren waren 95,5% aufgabenorientiert, 1% eigenschaftsorientiert und 3,5% konnten nicht zugeordnet werden. Aufgrund dieser Verteilung haben wir beschlossen, keine Berechnungen über die Unterschiede zwischen der Anzahl der aufgabenorientierten und eigenschaftsorientierten Kommentare zu unseren Berechnungen der Gesamtzahl der Kommentare hinzuzufügen.

3.4. Einflüsse der MSF-Bewertungen (Teil i) auf die während der Feedbackgespräche diskutierten Stärken (Teil ii)

3.4.1. Skalenbasierte externe Bewertungen

Höhere skalierte externe Bewertungen pro Item (Β=0,39, β=0,30, p<0,05) erhöhten die Wahrscheinlichkeit, dass das Thema als Stärke angesprochen wurde, signifikant.

3.4.2. Positive Kommentare

Eine höhere Anzahl positiver Kommentare pro Item (Β=0,05, β=0,18, p<0,05) erhöhte die Wahrscheinlichkeit, dass das Thema als Stärke diskutiert wurde, signifikant.

Die Anzahl der Gesamtkommentare (Β=0,00, β=0,00, p=1,00), die Anzahl der negativen Kommentare (Β=0,00, β=0,01, p=0,90) und die Diskrepanz zwischen externen Bewertungen und Selbstbewertungen (Β=0,03, β=0,04, p=0,11) hatten keinen signifikanten Einfluss darauf, ob ein Thema als Stärke diskutiert wurde (siehe Tabelle 4 [Tab. 4]).

3.5. Einfluss der MSF-Bewertungen (Teil i) auf die Themen, die während des Feedbackgesprächs als Bereiche zur Verbesserung diskutiert wurden (Teil ii)

3.5.1. Negative Kommentare

Eine höhere Anzahl negativer Kommentare pro Item (Β=0,06. β=0,23. p<0,05) erhöhte die Wahrscheinlichkeit, dass das Thema als verbesserungswürdig diskutiert wurde, signifikant. Skalenbasierte externe Bewertungen (Β=-0,03. β=-0,06. p=0,12), die Gesamtzahl der Kommentare (Β=0,02. β=0,15. p=0,07), die Anzahl der positiven Kommentare (Β=-0,02. β=-0,13. p=0,10) und die Diskrepanz zwischen externen Bewertungen und Selbstbewertung (Β=-0,01. β=-0,04. p=0,14) hatten keinen signifikanten Einfluss darauf, ob ein Thema als Bereich der Verbesserung diskutiert wurde (siehe Tabelle 5 [Tab. 5]).

3.6. Einflüsse der MSF-Bewertungen (Teil i) und der diskutierten Themen (Teil ii) auf die Lernziele (Teil iii)

3.6.1. Anzahl der Kommentare

Eine höhere Anzahl von Kommentaren pro Item erhöhte signifikant (Β=0,04. β=0,43. p<0,05) die Wahrscheinlichkeit, dass das Thema in ein Lernziel umgesetzt wurde.

3.6.2. Als Bereich zur Verbesserung diskutiert

Die Diskussion eines Themas als Bereich zur Verbesserung (Β=0,029. β=0,19. p<0,05) erhöhte die Wahrscheinlichkeit, dass das Thema in ein Lernziel umgesetzt wurde, signifikant.

Skalenbasierte externe Bewertungen (Β=-0,06, β=-0,04, p=0,52), die Anzahl der positiven Kommentare (Β=-0,03. β=-0,21. p=0,21), die Anzahl der negativen Kommentare (Β=-0,01. β=-0,03. p=0,76), die Diskrepanz zwischen externen Bewertungen und Selbstbewertung (Β=0,01. β=0,01. p=0,88) und die Erwähnung eines Themas als Stärke hatten keinen signifikanten Einfluss auf dessen Übertragung in ein Lernziel (Β=0,01. β=0,01. p=0,79) (siehe Tabelle 6 [Tab. 6]).

Tabelle 6: Einflüsse auf Lernziele

4. Diskussion

Unsere Untersuchung zeigte, dass die als Stärken diskutierten Themen von den skalenbasierten Bewertungen und der Anzahl positiver Kommentare abhingen, während Bereiche zur Verbesserung von der Anzahl negativer Kommentare abhingen. Diskrepanzen zwischen der Selbstbewertung und den externen Bewertungen erhöhten nicht die Wahrscheinlichkeit einer Diskussion. Jedes Lernziel wurde durch die Anzahl der narrativen Kommentare beeinflusst und dadurch, ob das Thema als Bereich zur Verbesserung diskutiert worden war. Überraschend fanden wir eine Reihe von narrativen Kommentaren und Lernzielen, die über die im MSF-Fragebogen vorgeschlagenen Kompetenzen hinausgingen und sich auf weiter gefasste Konzepte bezogen. Wir sehen diese Ziele im Zusammenhang mit der Entwicklung der professionellen Identität, diskutieren sie unter 4.2. und schlagen auf der Grundlage dieser Ergebnisse Implikationen für die Praxis vor.

4.1. Narrative Kommentare

Der hohe Anteil an positiven narrativen Kommentaren deckt sich mit anderen Studien [23], [25]. Wir stellten einen höheren Anteil an aufgabenbezogenen Kommentaren fest [13], [23], was wahrscheinlich auf Unterschiede in der Schulung der Bewertenden oder das Fragebogendesign zurückzuführen ist. Sowohl Dory et al. [26], die „in-training assessment reports“ mit schriftlichem Feedback untersuchten, als auch Lockyer et al. [23], die MSF untersuchten, weisen darauf hin, dass bereits kleine Anpassungen im Format des Fragebogens die Qualität des Feedbacks verbessern können. Wir kamen zu dem Schluss, dass die spezifische Schulung der Bewertenden und die Formulierung der Fragen, die zu aufgabenbezogenen Kommentaren aufforderten, den Anteil der aufgabenbezogenen Kommentare erhöhten.

4.2. Lernziele und Zusammenhang mit der Entwicklung der professionellen Identität

Wir haben zwischen 1 und 4 Lernziele pro Feedbackgespräch beobachtet. Viele dieser Lernziele konnten nicht eindeutig mit einzelnen Items des MSF-Fragebogens in Verbindung gebracht werden; einige bezogen sich auf Kombinationen von Items, andere auf Aspekte der Entwicklung der Weiterzubildenden, die im Fragebogen nicht abgedeckt waren, z. B. Karrierepläne, Engagement in der Forschung oder persönliche Haltungen wie ein selbstbewussteres Auftreten. Dieser Fund kann durch die Theorie der Professional Identity Formation [5] betrachtet werden, welche erklärt, dass sich der Schwerpunkt der Lernziele während der Entwicklung einer Person in Weiterbildung von einzelnen, separaten Fähigkeiten zu breiteren, persönlicheren Zielen verlagern kann. Daher schlagen wir vor, die MSF-Gespräche mit Weiterzubildenden zu erweitern, um sowohl Entwicklungsziele als auch Lernziele zu berücksichtigen.

Unsere Erkenntnis, dass einige Lernziele offenbar keinen Bezug zu den Fragen des MSF-Fragebogens hatten, deutet darauf hin, dass der Fragebogen angepasst werden muss, um den zusätzlichen Bedürfnissen der Lernenden gerecht zu werden. Diese zusätzlichen Lernziele könnten auch auf Lücken im Curriculum hinweisen. Eine Analyse der Lernziele könnte daher genutzt werden, um das Weiterbildungscurriculum zu verbessern [27], indem übergeordnete Ziele aufgenommen werden.

Wenn die Lernziele über den Umfang des MSF-Fragebogens hinausgehen, wird deutlich, wie komplex die Messung der Wirksamkeit von MSF ist, da der MSF-Prozess sowohl Kompetenzen als auch übergeordnete Ziele berücksichtigt. Die Ausrichtung des Feedbackgesprächs auf diese zusätzlichen Ziele erhöht möglicherweise nicht direkt die Wirksamkeit von MSF als formative Kompetenzbewertung, erweitert jedoch deren Anwendungsbereich. Diese zusätzlichen Funktion könnte über die Bewertung von Kompetenzen hinausführen und die professionelle Identitätsentwicklung unterstützen. MSF könnte letzteres Ziel besser erfüllen, indem die Schulung von Supervisionspersonen und Weiterzubildenden um die zusätzlichen Inhalte erweitert wird und sie darauf vorbereitet werden, die übergeordneten Ziele besser zu formulieren. Um zu sehen, ob dies auch in einem internationalen Kontext gilt, sind weitere Untersuchungen erforderlich, da das MSF kontextabhängig ist, geprägt von unterschiedlichen Lernkulturen, einschliesslich anderer Formen der Bewertung in unterschiedlichen Weiterbildungscurricula.

4.3. Einflussfaktoren

Items wurden eher als Stärken diskutiert, wenn sie mehr positive Kommentare hatten und als Bereiche zur Verbesserung, wenn sie negativen Kommentare hatten. Höhere Bewertungen liessen eine Diskussion über Stärken erwarten, niedrigere Bewertungen hingegen liessen keine Diskussion über Bereiche zur Verbesserung erwarten; nur die Anzahl der negativen Kommentare war ein Indikator für eine Diskussion über Verbesserungen. Dies steht im Gegensatz zu Studien von Sargeant et al. [7] und Overeem et al. [15], die niedrige Bewertungen als Hauptmotiv für Veränderungen nannten. Eine aktuelle qualitative Studie [28] beschrieb, dass Feedback-Gespräche, die als summativ empfunden wurden, das Verhalten der Weiterzubildenden beeinflussten und sie dazu veranlassten, Schwächen zu verbergen. Ein Literatur-Review zum Verhalten der Beurteilenden [29] fasste zusammen, dass auch diese Gruppe diese Spannung empfand, was sie dazu veranlasste, unangenehme Information zu verschweigen. Dies könnte teilweise unsere Ergebnisse erklären, dass niedrige Bewertungen und die Diskrepanz zwischen externen Bewertungen und Selbstbewertungen nicht so häufig diskutiert wurden wie hohe Bewertungen. Eine Fokussierung auf den formativen Aspekt des Feedbacks könnte diese Barriere für ehrliche Gespräche verkleinern [29].

Ausserdem fanden wir, wie andere Studien, signifikante Unterschiede zwischen externen Bewertungen und Selbstbewertungen, konnten jedoch den beschriebenen Einfluss dieser Unterschiede auf die Gespräche oder die Lernziele nicht bestätigen [15], [18]. Auch hier ist es möglich, dass Supervisionspersonen es vermieden, direkt auf die Unterschiede hinzuweisen, um Spannungen während des Feedbackgesprächs zu vermeiden.

Eine Studie von Smither und Walker [13] mit Führungskräften ergab, dass eine kleine Anzahl negativer aufgabenbezogener Kommentare den stärksten Einfluss auf die Leistung hatte, während eine hohe Anzahl negativer Kommentare demotivierend wirkte. Die Anzahl der schriftlichen Kommentare lag in ihrer Studie bei durchschnittlich 6,8, während wir sogar 15 bis 66 negative Kommentare pro Person in Weiterbildung beobachteten. Wir vermuten, dass die Supervisionspersonen in unserer Studie verhindert haben, die Weiterzubildenden durch zu viele Kommentare zu überfordern.

Trotz der hohen Anzahl positiver narrativer Kommentare konzentrierten sich die Feedback-Gespräche eher auf Bereiche zur Verbesserung, möglicherweise weil korrigierendes Feedback als umsetzbarer empfunden wurde als bestätigendes Feedback. Ein Reflexionsmodell stützt diese Argumentation: Sargeant et al. [11] fanden heraus, dass Feedback, das nicht mit der Selbstwahrnehmung übereinstimmt, zu einer länger anhaltenden Reflexion führt; möglicherweise haben Weiterzubildende und der Supervisionspersonen unbewusst diesen Prozess berücksichtigt. Ausserdem wurde in unserer Studie bei der Schulung der Supervisionspersonen betont, dass Stärken und Bereiche zur Verbesserung im Gleichgewicht diskutiert werden sollten, jedoch nicht geschult, Ziele zu formulieren, die das bestehende Verhalten bestärken.

4.4. Implikationen für die Praxis

4.4.1. Entwicklung der professionellen Identität

Wir schlagen vor, den MSF-Fragebogen und die Schulung zu erweitern, um dem Bedürfnis der Weiterzubildenden nach übergeordneten Entwicklungszielen gerecht zu werden. Durch die Berücksichtigung sowohl spezifischer Kompetenzen als auch allgemeinerer Entwicklungsziele könnte MSF neben der Bewertung von Kompetenzen auch die Entwicklung der professionellen Identität unterstützen.

4.4.2. Format des MSF-Fragebogens und Schulung der Bewertenden

Für die klar definierten Kompetenzen empfehlen wir die Verwendung aufgabenbezogener Items, um ein qualitativ hochwertiges Feedback mit spezifischen, aufgabenorientierten Kommentaren zu erzielen.

4.4.3. Feedbackgespräch

Wir empfehlen einen formativen Fokus in Feedbackgesprächen, um ehrliche Diskussionen zu fördern und Spannungen abzubauen. Wenn Supervisionspersonen und Weiterzubildende entscheiden, welche Themen besprochen werden sollen, sollten sie skalenbasierte Bewertungen mit narrativen Kommentaren kombinieren, da beide wertvolle Informationen für die Lernziele liefern.

4.5. Limitationen und Stärken der Studie

Wir waren dadurch eingeschränkt, dass wir die Gespräche nicht direkt beobachten konnten; wir analysierten nur die Daten, die in das Feedback-Gespräch einflossen, begrenzte Notizen und die Lernziele als Ergebnis. Da sich unsere Studie detailliert auf die quantitativen Daten des MSF konzentrierte, konnten wir andere Faktoren, die den Prozess ebenfalls beeinflussten, wie die Wahrnehmung der Weiterzubildenden oder ihre emotionale Reaktion auf das Feedback, nicht untersuchen.

Unser einzigartiger Ansatz, den MSF-Prozess in einzelne Teile zu betrachten, half uns, die Wechselwirkungen zwischen skalenbasierten Bewertungen, narrativen Kommentaren, Feedback-Gesprächen und Lernzielen zu verstehen und so den komplexen Prozess zu beleuchten. Da nur wenige Studien die Einflüsse auf das Feedbackgespräch und die Art und Weise, wie Feedback in Lernziele umgesetzt wurde, quantitativ untersucht haben, liefern unsere Daten wertvolle Erkenntnisse. Da eine quantitative Studie nur Zusammenhänge zwischen Daten aufzeigen, aber nicht erklären kann, sind qualitative Studien erforderlich, um die Perspektive der Weiterzubildenden und Supervisionspersonen zu unseren Ergebnissen und Empfehlungen zu untersuchen.

5. Fazit

Unsere Studie konzentrierte sich auf das Feedbackgespräch, ein entscheidendes Element im MSF-Prozess. Wir haben festgestellt, dass ein Teil der während des Gesprächs festgelegten Lernziele die professionelle Entwicklung der Weiterzubildenden betraf. Daher schlagen wir vor, MSF nicht nur als formatives Bewertungsformat zu nutzen, sondern als Begleitmassnahme, welche Weiterzubildende bei der Entwicklung der professionellen Identität unterstützt. Wir ermutigen Supervisionspersonen und Weiterzubildende, Themen der Entwicklung der professionellen Identität, wie Karrierepläne, Engagement in der Forschung oder persönliche Haltungen, ausdrücklich in regelmässige Bewertungen und Feedbackgespräche einzubeziehen. Unsere Erkenntnisse bieten praktische Empfehlungen zur Verbesserung der Nutzung von MSF und zeigen einen Weg auf, wie die Entwicklung der professionellen Identität während der ärztlichen Weiterbildung unterstützt werden kann.

Anmerkungen

Autorenschaft

Die Autor*in Kathrin Neuhaus und Sören Huwendiek teilen sich die Letztautorenschaft.

ORCIDs der Autor*innen

- Eva K. Hennel: [0000-0002-7625-5785]

- Felicitas-M. Lahner: [0000-0001-6697-3698]

- Noemi Zweifel: [0000-0001-7313-3929]

- Sigrid Harendza: [0000-0002-7920-8431]

- Kathrin Neuhaus: [0000-0003-2438-1779]

- Sören Huwendiek: [0000-0001-6116-9633]

Interessenkonflikt

Die Autor*innen erklären, dass sie keinen Interessenkonflikt im Zusammenhang mit diesem Artikel haben.

Literatur

[1] Sargeant J. Reflecting upon multisource feedback as ‘assessment for learning’. Perspect Med Educ. 2015;4(2):55-56. DOI: 10.1007/s40037-015-0175-y[2] Norcini J, Burch V. Workplace-based assessment as an educational tool: AMEE Guide No. 31. Med Teach. 2007;29(9):855-871. DOI: 10.1080/01421590701775453

[3] Boursicot K, Etheridge L, Setna Z, Sturrock A, Ker J, Smee S, Sambandam E. Performance in assessment: consensus statement and recommendations from the Ottawa conference. Med Teach. 2011;33(5):370-383. DOI: 10.3109/0142159X.2011.565831

[4] Boursicot K, Kemp S, Wilkinson T, Findyartini A, Canning C, Cilliers F, Fuller R. Performance assessment: Consensus statement and recommendations from the 2020 Ottawa Conference. Med Teach. 2021;43(1):58-67. DOI: 10.1080/0142159X.2020.1830052

[5] Jarvis-Selinger S, Pratt DD, Regehr G. Competency is not enough: integrating identity formation into the medical education discourse. Acad Med. 2012;87(9):1185-1190. DOI: 10.1097/ACM.0b013e3182604968

[6] Overeem K, Lombarts M, Arah OA, Klazinga NS, Grol RP, Wollersheim HC. Three methods of multi-source feedback compared: a plea for narrative comments and coworkers’ perspectives. Med Teach. 2010;32(2):141-147. DOI: 10.3109/01421590903144128

[7] Sargeant J, Mann K, Sinclair D, Van der Vleuten C, Metsemakers J. Challenges in multisource feedback: intended and unintended outcomes. Med Educ. 2007;41(6):583-591. DOI: 10.1111/j.1365-2923.2007.02769.x

[8] Burford B, Illing J, Kergon C, Morrow G, Livingston M. User perceptions of multi-source feedback tools for junior doctors. Med Educ. 2010;44(3):165-176. DOI: 10.1111/j.1365-2923.2009.03565.x

[9] Overeem K, Wollersheim H, Driessen E, Lombarts K, Van De Ven G, Grol R, Arah O. Doctors’ perceptions of why 360‐degree feedback does (not) work: a qualitative study. Med Educ. 2009;43(9):874-882. DOI: 10.1111/j.1365-2923.2009.03439.x

[10] Sargeant J, Mann KV, Ferrier SN, Langille DB, Muirhead PD, Hayes VM, Sinclair DE. Responses of rural family physicians and their colleague and coworker raters to a multi-source feedback process: a pilot study. Acad Med. 2003;78(10 Suppl):S42-S44. DOI: 10.1097/00001888-200310001-00014

[11] Sargeant JM, Mann KV, van der Vleuten CP, Metsemakers JF. Reflection: a link between receiving and using assessment feedback. Adv Health Sci Educ Theory Pract. 2009;14(3):399-410. DOI: 10.1007/s10459-008-9124-4

[12] Hall J, Atkinson A, Chan M-K, Tourian L, Thoma B, Pattani R. The Clinical Learning Environment in CanMEDS 2025. Can Med Educ J. 2023;14(1):41-45. DOI: 10.36834/cmej.75537

[13] Smither JW, Walker AG. Are the Characteristics of Narrative Comments Related to Improvement in Multirater Feedback Ratings Over Time? J Appl Psychol. 2004;89(3):575-581. DOI: 10.1037/0021-9010.89.3.575

[14] Ferguson J, Wakeling J, Bowie P. Factors influencing the effectiveness of multisource feedback in improving the professional practice of medical doctors: a systematic review. BMC Med Educ. 2014;14:76. DOI: 10.1186/1472-6920-14-76

[15] Overeem K, Wollersheimh HC, Arah OA, Cruijsberg JK, Grol RP, Lombarts KM. Factors predicting doctors’ reporting of performance change in response to multisource feedback. BMC Med Educ. 2012;12:52. DOI: 10.1186/1472-6920-12-52

[16] Al Khalifa K, Al Ansari A, Violato C, Donnon T. Multisource Feedback to Assess Surgical Practice: A Systematic Review. J Surg Educ. 2013;70(4):475-486. DOI: 10.1016/j.jsurg.2013.02.002

[17] Violato C, Lockyer JM, Fidler H. Changes in performance: a 5year longitudinal study of participants in a multisource feedback programme. Med Educ. 2008;42(10):1007-1013. DOI: 10.1111/j.1365-2923.2008.03127.x

[18] Wood L, Hassell A, Whitehouse A, Bullock A, Wall D. A literature review of multi-source feedback systems within and without health services, leading to 10 tips for their successful design. Med Teach. 2006;28(7):e185-e191. DOI: 10.1080/01421590600834286

[19] Sargeant J, McNaughton E, Mercer S, Murphy D, Sullivan P, Bruce DA. Providing feedback: Exploring a model (emotion, content, outcomes) for facilitating multisource feedback. Med Teach. 2011;33(9):744-749. DOI: 10.3109/0142159X.2011.577287

[20] Mackillop L, Parker-Swift J, Crossley J. Getting the questions right: non-compound questions are more reliable than compound questions on matched multi-source feedback instruments. Med Educ. 2011;45(8):843-848. DOI: 10.1111/j.1365-2923.2011.03996.x

[21] Frank JR, Danoff D. The CanMEDS initiative: implementing an outcomes-based framework of physician competencies. Med Teach. 2007;29(7):642-647. DOI: 10.1080/01421590701746983

[22] Hennel EK, Subotic U, Berendonk C, Stricker D, Harendza S, Huwendiek S. A german-language competency-based multisource feedback instrument for residents: development and validity evidence. BMC Med Educ. 2020;20(1):357. DOI: 10.1186/s12909-020-02259-2

[23] Lockyer JM, Sargeant J, Richards SH, Campbell JL, Rivera LA. Multisource Feedback and Narrative Comments: Polarity, Specificity, Actionability, and CanMEDS Roles. J Contin Educ Health Prof. 2018;38(1):32-40. DOI: 10.1097/CEH.0000000000000183

[24] R Core Team. R: A language and environment for statistical computing. R Foundation for Statistical Computing, Vienna, Austria: R Core Team; 2021. Zugänglich unter/available from: https://www.R-project.org/

[25] Brown JM, Lowe K, Fillingham J, Murphy PN, Bamforth M, Shaw NJ. An investigation into the use of multi-source feedback (MSF) as a work-based assessment tool. Med Teach. 2014;36(11):997-1004. DOI: 10.3109/0142159X.2014.909920

[26] Dory V, Cummings BA, Mondou M, Young M. Nudging clinical supervisors to provide better in-training assessment reports. Perspect Med Educ. 2020;9(1):66-70. DOI: 10.1007/s40037-019-00554-3

[27] Thomas PA, Kern DE, Hughes MT, Chen BY. Curriculum development for medical education: a six-step approach. Baltimore (MA): JHU Press; 2016.

[28] Huffman BM, Hafferty FW, Bhagra A, Leasure EL, Santivasi WL, Sawatsky AP. Resident impression management within feedback conversations: A qualitative study. Med Educ. 2020;55(2):266-274. DOI: 10.1111/medu.14360

[29] Scarff CE, Bearman M, Chiavaroli N, Trumble S. Keeping mum in clinical supervision: private thoughts and public judgements. Med Educ. 2019;53(2):133-142. DOI: 10.1111/medu.13728