[Wie entwickle ich ein psychologisches Test- oder Fragebogenverfahren?]

Marianne Giesler 1Götz Fabry 2

1 Freiburg i. Brsg., Deutschland

2 Universität Freiburg, Institut für Medizinische Psychologie und Medizinische Soziologie, Freiburg i. Brsg., Deutschland

Zusammenfassung

Ziel dieses Gewusst-wie-Artikels ist es, Ärztinnen und Ärzte sowie anderen Gesundheitsfachkräften, die im Bereich Medizinische Ausbildungsforschung tätig sind, ein Grundverständnis der Konstruktion von Test- oder Fragebogenverfahren zu vermitteln. Die Konstruktion solcher Verfahren ist insgesamt zu komplex, um sie auf einigen wenigen Seiten zu beschreiben. Daher kann dieser Beitrag Leserinnen und Leser lediglich in die Lage versetzen, solche Verfahren grob zu bewerten, bzw. eine Vorstellung davon zu vermitteln, wie solche Verfahren im Allgemeinen konstruiert werden.

Der Beitrag skizziert verschiedene Phasen der Test- bzw. Fragebogenkonstruktion. Er beginnt mit der inhaltlichen Phase, in der ein Konstrukt nach Möglichkeit mit Rückgriff auf Theorien und Modelle definiert wird. Hier werden Items formuliert, ein Antwortformat ausgewählt, die Instruktion formuliert und Vortests durchgeführt. In der strukturellen Phase wird die Struktur des Tests bzw. Fragebogens mittels geeigneter teststatistischer Verfahren und Kennwerte überprüft. In einer letzten Phase (externe Phase) werden weitere Belege für die Validität von Test- bzw. Fragebogenergebnissen gesammelt. Die Validierung solcher Verfahren stellt jedoch keinen abschließenden Schritt der Test- bzw. Fragebogenkonstruktion dar, denn sie wird in allen Phasen der Test- bzw. Fragebogenkonstruktion berücksichtigt. Die Validierung von Test- und Fragebogenverfahren ist theoretisch und methodisch anspruchsvoll und sollte nie als abgeschlossen betrachtet werden. Es sollte strenggenommen auch nicht davon gesprochen werden, dass ein Test bzw. Fragebogen valide ist, da Validität keine Eigenschaft solcher Verfahren ist. Es können nur Aussagen und Schlussfolgerungen valide sein, die auf der Grundlage von Test- bzw. Fragebogenergebnissen getroffen werden.

Schlüsselwörter

Phasen der Test- bzw. Fragebogenkonstruktion, Reliabilität, Validität, Generierung und Formulierung von Items

1. Ziel dieses Gewusst-wie-Artikels

In der medizinischen Ausbildungsforschung werden häufig Test- oder Fragebogenverfahren eingesetzt, z.B. um Motivation, Empathie oder auch bestimmte Leistungen von Studierenden zu messen. In der Ausbildung von Ärztinnen, Ärzten und medizinischen Fachkräften werden allerdings kaum Kompetenzen vermittelt, die es erlauben, die Qualität solcher Verfahren zu bewerten, Messinstrumente zu entwickeln oder einen bestehenden Fragebogen zu übersetzen. Dieser Gewusst-wie-Artikel soll daher die Entwicklung psychologischer Test- und Fragebogenverfahren erläutern und anschaulich machen.

Der Prozess der Test- bzw. Fragebogenkonstruktion ist komplex und zeitaufwendig. Es gibt verschiedene Fachbücher, in denen dieser Prozess ausführlich auf meist über 200 Seiten beschrieben wird [1], [2]. Ein kurzer Artikel kann daher Leserinnen und Leser lediglich in die Lage versetzen, Test- und Fragebogenverfahren grob zu bewerten, und ebenso eine Vorstellung vermitteln, wie solche Verfahren nach der sog. klassischen Testtheorie (s.u.) im Allgemeinen konstruiert werden.

In den folgenden Kapiteln wird zunächst kurz erläutert, welche Arten von Test- bzw. Fragebogenverfahren sich unterscheiden lassen. Anschließend werden verschiedene Phasen der Konstruktion solcher Verfahren skizziert.

2. Welche Arten von Test- bzw. Fragebogenverfahren lassen sich unterscheiden?

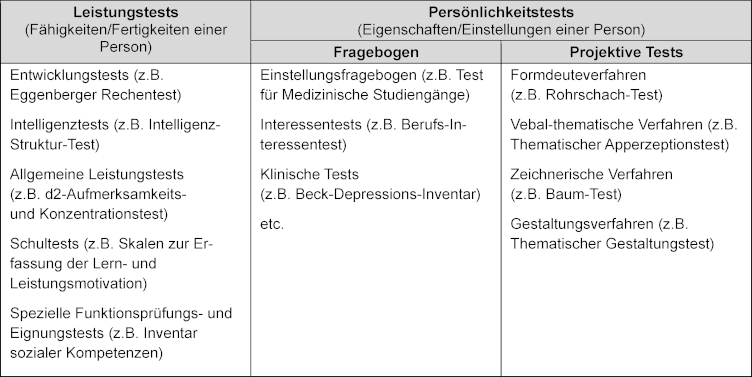

Psychologische Test- bzw. Fragebogenverfahren lassen sich drei Bereichen zuordnen: Leistungstests, Persönlichkeitsfragebögen und Projektive Verfahren [3]. Jeder Bereich kann wiederum weiter unterteilt werden (siehe Tabelle 1 [Tab. 1]). Diese Verfahren erfassen Fähigkeiten, Fertigkeiten, Eigenschaften und Zustände von Personen, die oftmals nicht direkt beobachtbar sind. Diese Merkmale werden mit Hilfe von beobachtbarem Verhalten erschlossen und als Konstrukte bezeichnet. Bekannte, in der medizinischen Ausbildungsforschung verwendete psychologische Konstrukte sind z.B. Motivation, Selbstwirksamkeit, Resilienz, Reflexionsfähigkeit, Empathie. Da Konstrukte nicht direkt gemessen werden können, werden sie als latente Variablen bezeichnet, für die Items als Indikatoren herangezogen werden [2].

Tabelle 1: Psychologische Test- und Fragebogenverfahren – ein Überblick mit Beispielen [3]

Die meisten psychologischen Test- und Fragebogenverfahren beruhen auf den Annahmen und den Konstruktionsprinzipien der sog. Klassischen Testtheorie (KTT) [4], [5], mit der berücksichtigt wird, dass Messungen einzelner Personen über verschiedene Messungen hinweg variieren können. Das Grundkonzept beinhaltet die Annahme, dass der beobachtete Wert X einer Person in einem Test aus einem „wahren“ Wert (true score) der Person und einem zufälligen Messfehler (random measurement error) besteht. Das Ergebnis eines Intelligenztests würde dementsprechend zum einen von der tatsächlichen Intelligenz der untersuchten Person, zum anderen aber auch von unsystematischen Einflüssen, z.B. tageszeitlich bedingten Leistungsschwankungen beeinflusst. Würde man unendlich viele Messungen durchführen, dann entspräche der Mittelwert dieser Messungen dem tatsächlichen Intelligenzwert.

Neben der KTT gibt es die Probabilistische Testtheorie (PTT), die manchmal auch Item-Response Theorie (IRT) genannt wird. Diese Theorie beruht auf der Annahme, dass die Wahrscheinlichkeit einer bestimmten Antwort auf ein Item von Merkmalen des Items und der Ausprägung des zu messenden latenten Merkmals der Person abhängt [5]. Nach Rost [4] handelt es sich bei den beiden Testtheorien KTT und PTT nicht, wie häufig beschrieben, um konkurrierende, sondern um komplementäre Verfahren, da die eine Theorie dort ansetzt, wo die andere aufhört bzw. weil beide Testtheorien weitgehend auf denselben Annahmen beruhen. Nähere Ausführungen zur PTT finden sich in Bühner [2] und Döring und Bortz [5].

3. Wie werden Test- bzw. Fragebogenverfahren entwickelt?

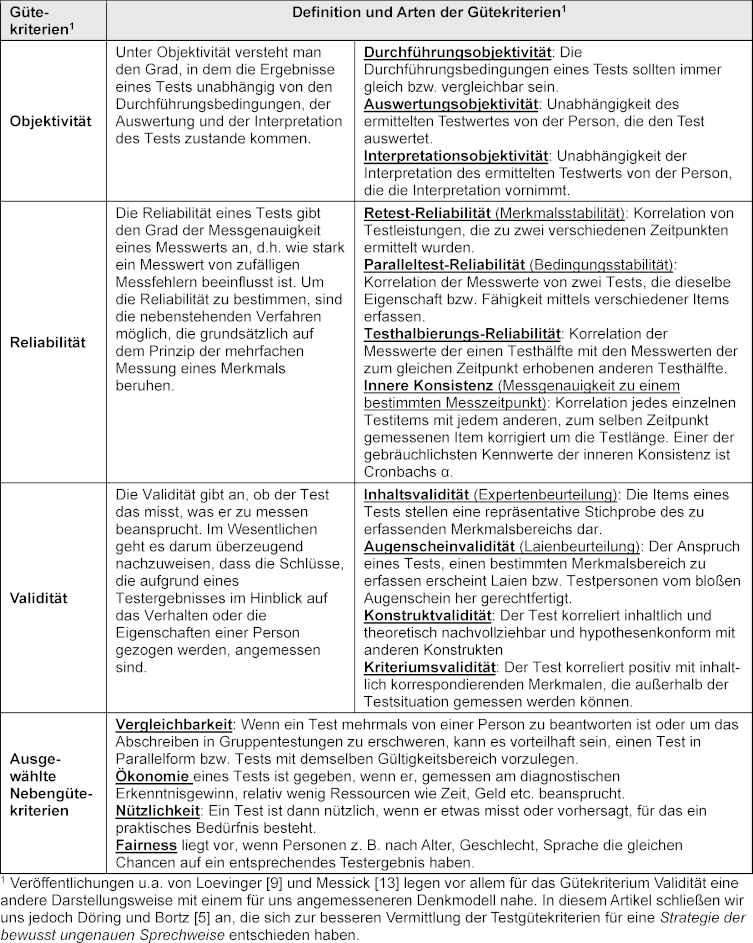

Bei der Entwicklung von Test- bzw. Fragebogenverfahren sind sog. Testgütekriterien zu beachten (siehe Tabelle 2 [Tab. 2]). Die Entwicklung solcher Verfahren beginnt mit der Festlegung bzw. Definition des zu erfassenden Konstrukts. Danach werden Items (Aufgaben oder Aussagen) formuliert und das Antwortformat ausgewählt. Nach einem Vortest wird das Verfahren an einer oder mehreren Stichproben gezielt erprobt. Wenn die dafür erforderliche Menge an Daten vorliegt, wird analysiert, wie zuverlässig der Test bzw. Fragebogen das Konstrukt misst (Reliabilität) und ob er das Konstrukt misst, das er zu messen beansprucht (Validität).

Tabelle 2: Traditionelle Test-Gütekriterien [2], [5], [10], [19]

3.1. Definition des Konstrukts

Zur Definition und Operationalisierung des Konstrukts werden, soweit vorhanden, Theorien oder Modelle herangezogen. Beispiele für Konstrukte, zu denen es gute Theorien und Modelle gibt, auf deren Grundlage psychologische Tests entwickelt wurden, sind etwa Motivation und Lernstrategien. Sind Theorien und Modelle nicht verfügbar, kann der Konstruktraum nach ausgiebigem Literaturstudium eingeengt und es können Indikatoren (z.B. konkrete Aussagen oder Verhaltensweisen) des Konstrukts bestimmt werden. Ein aktuelles Beispiel aus der medizinischen Ausbildungsforschung, bei dem ein solches Vorgehen notwendig ist, ist die Reflexionsfähigkeit. Hier gibt es zwar auch verschiedene Modelle und Theorien, diese unterscheiden sich allerdings teilweise deutlich darin, was unter Reflexionsfähigkeit jeweils verstanden wird. Insofern müsste für die Entwicklung eines Testverfahrens für Reflexionsfähigkeit zunächst definiert werden, welche Indikatoren von Reflexionsfähigkeit auf Grundlage welcher Vorarbeiten berücksichtigt werden sollen. Im Rahmen der Konstrukt-Definition soll zudem auch ermittelt werden, inwieweit Beziehungen sowie Überschneidungen bzw. Überlappungen zu anderen Konstrukten bestehen (nomologisches Netzwerk) [2]. So wird z.B. diskutiert, inwiefern die Persönlichkeitseigenschaft Offenheit für Erfahrungen mit Kreativität in Verbindung steht [6].

Die Güte der Definition des Konstrukts entscheidet darüber, wie leicht sich Items generieren lassen. Eine detaillierte Definition, die erforderliche Abgrenzungen gegenüber anderen Konstrukten berücksichtigt, erhöht darüber hinaus die Wahrscheinlichkeit für die Inhaltsvalidität des Konstrukts [1], [2].

3.2. Generierung und Formulierung von Items

Bei der Generierung von Items kann auf unterschiedliche Quellen zurückgegriffen werden [1]. So können Items

- aus Theorien bzw. nach einem ausgiebigen Literaturstudium bzw. nach einer systematischen Literaturrecherche abgeleitet werden,

- aus Ergebnissen von Voruntersuchungen (Interviews, Fokusgruppen-Gespräche etc.) generiert werden,

- in Anlehnung an bestehende Testverfahren formuliert werden,

- von Expertinnen und Experten formuliert werden.

Auch bei der Item-Generierung sind die Ziele des zu konstruierenden Tests zu berücksichtigen [2]. Ist das Ziel, Eigenschafts- oder Fähigkeitsausprägungen von Personen zu erfassen, so sollten inhaltsvalide Items formuliert werden. Ein Test zur Erfassung von Progredienzangst, d.h. Angst vor dem Voranschreiten einer Erkrankung, ist dann inhaltsvalide, wenn die Testitems eine repräsentative Stichprobe des gesamten Bereichs von Progredienzangst darstellen (z.B. kognitive, emotionale und verhaltensbezogene Aspekte). Es sollte dabei darauf geachtet werden, dass mit den Items nur ein Konstrukt erfasst wird. Darüber hinaus sollten alle Indikatoren eines Konstrukts miteinander korrelieren [2].

Zur Sicherung der Inhaltsvalidität des Tests sollte bei der Item-Generierung auf eine repräsentative und ausreichende Item-Menge geachtet werden. Die Anzahl der Items des Testentwurfs sollte größer sein als die geplante Item-Anzahl der Endversion [2].

Vor Beginn der Itemformulierung sollte darüber entschieden werden, wie die Items formuliert werden sollen. Sie können beispielsweise wie folgt formuliert werden:

- In Frageform: Fühlen Sie sich von Angehörigen anderer Gesundheitsberufe respektiert?

- Als Statements: Ich fühle mich von Angehörigen anderer Gesundheitsberufe respektiert.

- In 1. Person Singular: Ich arbeite gerne mit Angehörigen anderer Gesundheitsberufe zusammen.

- In unpersönlicher Form: Man arbeitet hier gerne mit Angehörigen anderer Gesundheitsberufe zusammen.

Die Items sollten inhaltlich schlüssig und verständlich sein [1], [2]. Unter anderem bedeutet dies, dass Fremdwörter oder eine komplizierte Satzkonstruktion zu vermeiden sind. Auch sollten die Items inhaltlich eindeutig sein. Hierzu sind nach Möglichkeit u.a. Konditionalaussagen oder Konjunktionen zu vermeiden. Auch sollten Negationen (insbes. doppelte Verneinungen) vermieden werden.

3.3. Auswahl des Antwortformats

Genauso wichtig wie die Formulierung der Items ist die Auswahl passender Antwortvorgaben. Häufig finden bei psychologischen Test- und Fragebogenverfahren Ratingskalen (meist sog. Likert-Skalen) Anwendung, deren Kategorien bzw. Abstufungen unterschiedlich benannt werden. Oft anzutreffen sind Benennungen wie „trifft nicht zu“ bis „trifft zu“ oder „sehr schlecht“ bis „sehr gut“. Ratingskalen können zudem unterschiedlich abgestuft sein. Hierbei sind Antwortskalen mit bis zu 7 Stufen akzeptabel [2]. Des Weiteren ist zu klären, ob die Antwortstufen der Items unipolar (z.B. „nie“ bis „sehr oft“) oder bipolar (z.B. „Ablehnung „teilweise Ablehnung“, „weder Ablehnung noch Zustimmung“, „teilweise Zustimmung“, „Zustimmung“) vorgegeben werden sollen. Neben der verbalen Benennung der Antwortstufen können auch visuelle Hilfsmittel verwendet werden (z.B. Smileys).

3.4. Formulierung der Instruktion

Die Instruktion hat zum Ziel, Befragte mit dem Inhalt und Ziel der Befragung vertraut zu machen, Hinweise zur Beantwortung des Fragebogens zu geben und über datenschutzrechtliche Regelungen aufzuklären [7]. Sie hat eine zentrale Funktion, denn sie bereitet nicht nur auf die Beantwortung des Tests vor, sondern kann bei den zu befragenden Personen eine Vor-Einstellung in Bezug auf die zu erledigende Aufgabe erzeugen [1]. Eine Instruktion wird meist erst am Ende des Konstruktionsprozesses formuliert, wenn die Items und Antwortalternativen festgelegt sind. Neben einer Angabe des Ziels bzw. des Zwecks des Tests bzw. Fragebogens enthält eine Instruktion i.d.R. Hinweise, dass

- die Teilnahme freiwillig ist und keine Nachteile bei einer Nichtteilnahme zu befürchten sind,

- alle Items zu lesen und zügig zu beantworten sind,

- die Items nacheinander zu bearbeiten sind und kein Item ausgelassen werden soll, auch wenn dies einmal schwierig erscheinen sollte, und dass in diesem Fall stets angekreuzt werden sollte, was „am ehesten“ zutrifft,

- die Anonymität bzw. die vertrauliche Behandlung der individuellen Angaben entsprechend den geltenden datenschutzrechtlichen Bestimmungen gewährleistet werden.

3.5. Durchführung von Vortests

Die Durchführung eines oder auch mehrerer Vortests ist eine weitere wichtige Voraussetzung der Entwicklung eines Test- oder Fragebogenverfahrens. Für dessen Durchführung existieren jedoch keine allgemein akzeptierten Regeln. Beispielsweise variieren die Angaben sehr stark, wenn es darum geht, die Höhe der hierfür notwendigen Fallzahlen festzulegen [8]. In der Regel wird jedoch eine kleine Zahl von Personen aufgefordert, Rückmeldung über die Verständlichkeit der Items und der Instruktion zu geben und über Schwierigkeiten zu berichten, die bei der Bearbeitung des Verfahrens aufgefallen sind. Wichtig ist, dass diese Personen der späteren Zielgruppe des Tests bzw. Fragebogens möglichst ähnlich sind, z.B. was das Sprachverständnis angeht. Vortests liefern auch Informationen über die benötigte Durchführungszeit, das Interesse der Befragten an der Thematik sowie über die Häufigkeitsverteilungen der Antworten. Auf Basis der Rückmeldungen wird das Verfahren dann ggf. modifiziert.

4. Teststatistische Überprüfung von psychologischen Test- und Fragebogenverfahren

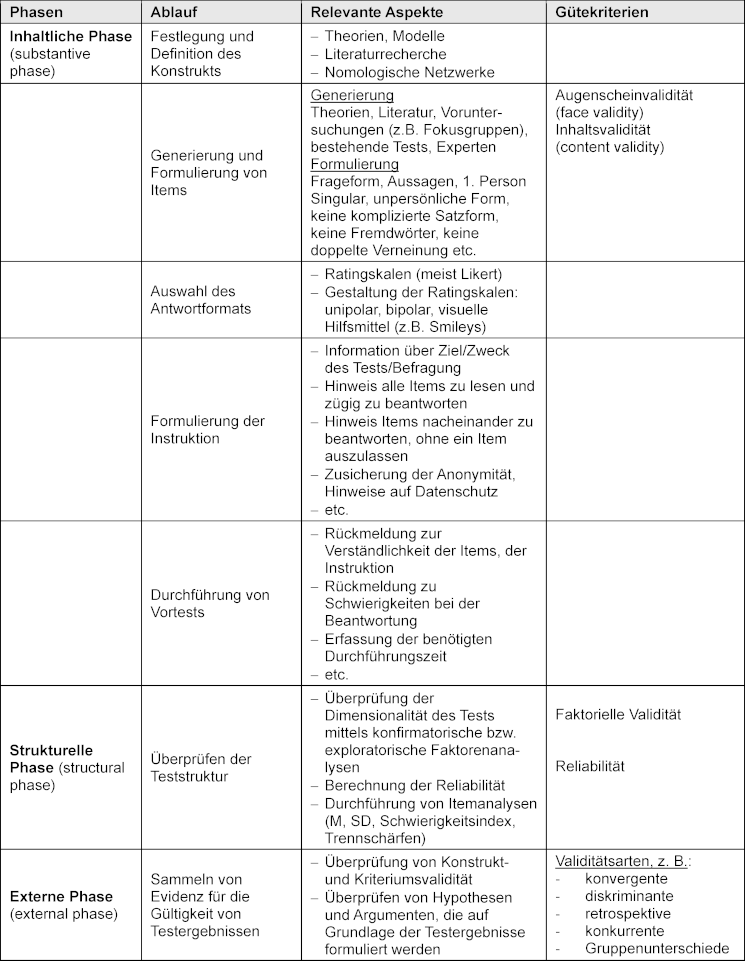

In Anlehnung an die von Loevinger [9] herausgearbeiteten Phasen kann der Prozess der teststatischen Überprüfung wie folgt eingeteilt werden:

- Inhaltliche Phase (substantive phase): Während dieser Phase wird das Messinstrument theoretisch und unter Einbeziehung verfügbarer Literatur fundiert. Es werden Vortests durchgeführt, um die Verständlichkeit der Items und Probleme bei deren Beantwortung abzuklären.

- Strukturelle Phase (structural phase): Das Hauptaugenmerk dieser zweiten Phase richtet sich auf die Überprüfung der strukturellen (z.B. faktorielle Struktur) und weiterer psychometrischen Eigenschaften (z.B. Item-Korrelationen) des Verfahrens.

- Externe Phase (external phase): In dieser Phase sollte das Ausmaß der Übereinstimmung des Messinstruments mit anderen Kriterien und ggf. ähnlichen Verfahren überprüft werden.

Alle bisherigen Beschreibungen in diesem Gewusst-wie-Artikel lassen sich der inhaltlichen Phase zuordnen (siehe Tabelle 3 [Tab. 3]). In den nachfolgenden Abschnitten geht es schwerpunktmäßig um die konkrete teststatistische Überprüfung der Test- bzw. Fragebogenverfahren, die den anderen beiden Phasen zuzuordnen sind.

Tabelle 3: Übersicht der Phasen der Konstruktion von Test- und Fragebogenverfahren (siehe Kapitel 4)

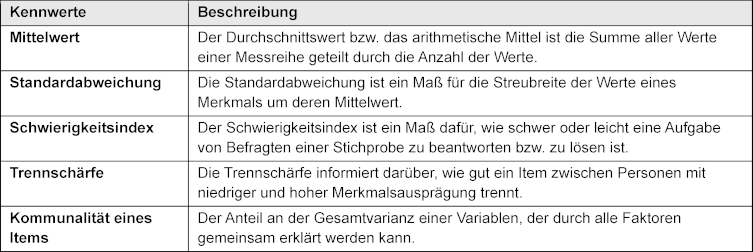

4.1. Strukturelle Phase

In der inhaltlichen Phase kann bereits die Augenschein- und Inhaltsvalidität eines Test- bzw. Fragebogenverfahrens sichergestellt werden. Die Überprüfung der strukturellen und psychometrischen Eigenschaften von Tests bzw. Fragebögen kann jedoch erst dann stattfinden, wenn das Verfahren von Personen der jeweiligen Zielgruppe beantwortet wurde (Datenerhebung). Es sollte zunächst eine Dimensionsanalyse mittels Faktorenanalysen (statistische Verfahren, die die Variablen gemäß ihrer Interkorrelation bündeln) erfolgen (faktorielle Validität) und anschließend eine Bestimmung der Reliabilität des Tests und eine Itemanalyse durchgeführt werden [10]. Ist der Stichprobenumfang jedoch zu gering [2], um Dimensionsanalysen durchzuführen, können zunächst vorläufige Reliabilitätsberechnungen durchgeführt werden und die Items im Hinblick auf ihre Schwierigkeit, Trennschärfe und Interkorrelationen (Itemanalysen) analysiert werden (siehe Tabelle 4 [Tab. 4]).

Tabelle 4: Beschreibung von teststatistischen Kennwerten

Die in der einschlägigen Literatur angegebenen erforderlichen Stichprobengrößen zur Berechnung von Faktorenanalysen variieren sehr stark. Nach MacCallum et al. [11] sind die gängigen Faustregeln zur Planung der Stichprobengröße problematisch, da diese von der Anzahl der Items pro Faktor und der Höhe der Kommunalität (Anteil der Varianz einer Variablen, der durch die Faktoren erklärt wird) eines jeden Items bestimmt wird. Die Kommunalitäten sind jedoch in der Regel nicht vorab bekannt. Von daher soll hier trotz der genannten Problematik zur groben Orientierung zumindest erwähnt werden, dass für Faktorenanalysen verschiedentlich empfohlen wurde, eine Anzahl von zu Befragenden einzuplanen, die mindestens fünf- bis zehnmal so groß ist wie die Anzahl der Items.

Ist die Stichprobengröße ausreichend zur Durchführung von Faktorenanalysen und liegt eine Hypothese bzw. ein Modell zu den Dimensionen des Tests vor, sollte eine konfirmatorische Faktorenanalyse durchgeführt werden. Gibt es keine gesicherten Annahmen über die Zusammenhänge zwischen den Items, ist eine exploratorische Faktorenanalyse zu empfehlen.

4.2. Externe Phase

Die Validierung eines Test- bzw. Fragebogenverfahrens ist theoretisch und methodisch anspruchsvoll und sollte nie als abgeschlossen betrachtet werden [5], [12]. Insofern sollte strenggenommen auch nicht davon gesprochen werden, dass ein Test bzw. Fragebogen valide ist, da Validität keine Eigenschaft von Tests bzw. Fragebögen ist (siehe 4.2.2). Mehr oder weniger valide können nur Aussagen und Schlussfolgerungen sein, die auf der Grundlage von Test- bzw. Fragebogenergebnissen getroffen werden.

Die Validierung von Test- bzw. Fragebogenverfahren (bzw. genauer von Test- bzw. Fragbogenergebnissen) beinhaltet verschiedene Aspekte. Dabei hat sich das Verständnis, welche Indikatoren als Hinweise auf Validität gelten können, im Lauf der Zeit verändert. Nachfolgend wird zunächst das traditionelle Validitätskonzept dargestellt. Im Anschluss daran wird der Validitätsansatz von Messick [13] beschrieben, der den traditionellen Ansatz ergänzt.

4.2.1. Konstrukt- und Kriteriumsvalidität

Zunächst kann festgestellt werden, ob das im Test- bzw. Fragebogenverfahren erfasste Konstrukt inhaltlich und theoretisch begründet mit anderen theoretischen Konstrukten korreliert (Konstruktvalidität) und/oder ob die Test- bzw. Fragebogenwerte positiv mit inhaltlich korrespondierenden manifesten Merkmalen außerhalb der Testsituation im Zusammenhang stehen (Kriteriumsvalidität) [5].

Zur Feststellung der Konstruktvalidität können Messinstrumente eingesetzt werden, die entweder sog. konstruktnahe oder konstruktferne Merkmale erfassen. Im ersten Fall würde nach Campbell und Fiske [14], die konvergente Validität überprüft, im zweiten Fall die diskriminante Validität. Zur Konstruktvalidität zählt ebenfalls die zuvor beschriebene faktorielle Validität (siehe 4.1). Auch besteht die Möglichkeit, Unterschiede in den Testwerten ausgewählter Gruppen zu analysieren. D.h. ausgehend von theoretischen Überlegungen werden Unterschiede in den Testwerten verschiedener Gruppen postuliert (z.B. Alter, sozioökonomischer Status, Schulbildung) und empirisch überprüft [10]. Sofern sich diese Unterschiede bestätigen, wird dies als Beleg der Validität interpretiert.

Bei der Kriteriumsvalidität lassen sich ausgehend vom Zeitpunkt der Erfassung des Außenkriteriums mehrere Arten von Validität unterscheiden [5]. Die retrospektive Validität wird überprüft, wenn Werte eines Kriteriums (z.B. zurückliegende Schulnoten) zeitlich vor dem Einsatz des zu validierenden Tests (z.B. Schulleistungstest) erhoben wurden. Bei der konkurrenten Validität, auch Übereinstimmungsvalidität genannt, werden die Werte des Kriteriums (z.B. die in ärztlichen Konsultationen angegebene Beschwerden wie Schlaf- und Lustlosigkeit) (fast) zum selben Messzeitpunkt erfasst wie die zu validierenden Testwerte (z.B. Ergebnisse eines Messinstruments zur Erfassung der Ausprägung von Depression). Bei der prognostischen Validität wird der Kriteriumswert (z.B. Studienleistung) später als der zu validierende Testwert (z.B. Ergebnisse eines Eignungstests zum Medizinstudium) erhoben. Die Bestimmung der Kriteriumsvalidität setzt voraus, dass das gewählte Außenkriterium reliabel und valide ist.

Die inkrementelle Validität zählt ebenfalls zur Kriteriumsvalidität, wird jedoch eher selten überprüft. Wenn doch eine Überprüfung erfolgt, wird ein herkömmliches Verfahren herangezogen, das das Gleiche zu messen beansprucht wie das zu validierende Verfahren. Dabei sollte das neue Verfahren die Vorhersage des Außenkriteriums signifikant verbessern [5].

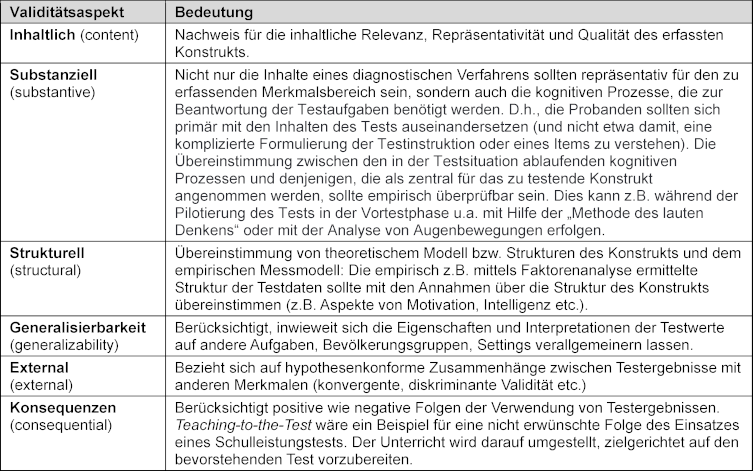

4.2.2. Argumentationsbasierte Validierungskonzepte

Das im vorigen Abschnitt beschriebene klassische Validitätskonzept wurde von Messick [13] erweitert. Die von ihm beschriebenen sechs generellen Validitätsaspekte, die für alle diagnostischen Messungen im Bildungsbereich gelten, basieren auf der Grundidee, dass die Validität einer diagnostischen Messung nicht allein als numerischer Koeffizient zu betrachten ist, sondern als theoretisch und empirisch fundiertes Argument für die Gültigkeit von Testwertinterpretationen. M.a.W. „It is incorrect to use the unqualified phrase the validity of the test” ([15], S.11), denn die Ergebnisse sind nicht nur eine Funktion der Items, sondern auch abhängig von den antwortenden Personen und dem Kontext der Bewertung [13]. Validität kann demnach als Argument für die Gültigkeit der Interpretation von Testwerten auf Grundlage von Evidenzen bzw. Erkenntnissen bezüglich dieser sechs Aspekte verstanden werden. In Tabelle 5 [Tab. 5] sind die von Messick beschriebenen Validitätsaspekte dargestellt. Dabei wird ersichtlich, dass nur die Aspekte substanzielle Validität, Generalisierbarkeit und Konsequenzen den traditionellen Ansatz ergänzen (siehe Tabelle 5 [Tab. 5]).

Tabelle 5: Validitätsansatz von Messick [5], [13], [20]

Ergänzend hat Messick [13] auf zwei mögliche Störfaktoren hingewiesen, die die Validität beeinträchtigen können. Das Konstrukt kann unterrepräsentiert sein, indem es zu eng gefasst und wichtige Dimensionen oder Facetten des Konstrukts nicht berücksichtigt wurden. Das wäre beispielsweise dann der Fall, wenn ein Test für Leistungsangst nur die emotionale Komponente erfasst und die kognitiven und physiologischen Komponenten außer Acht lässt. Die Validität kann aber auch durch konstrukt-irrelevante Varianz eingeschränkt werden, wenn Testaufgaben beispielsweise für einige Personen zu schwer oder zu leicht sind [13]. Dies ist z.B. der Fall, wenn die korrekte Beantwortung von Aufgaben in einem Mathematiktest auch von unangemessen hohen Anforderungen an das Sprachverständnis der antwortenden Personen abhängt.

Diese Erweiterungen des klassischen Validitätskonzepts werden mittlerweile u.a. von der American Educational Research Association (AERA) und der American Psychological Association (APA) vertreten [15], [16].

5. Übersetzung eines Test- oder Fragebogenverfahrens

Die Übersetzung von Tests bzw. Fragebögen erfolgte in der Vergangenheit häufig mit der Methode der Rückübersetzung. D.h. zuerst wurde das Verfahren in die Zielsprache übersetzt, dann wurde diese Übersetzung von einer anderen Person zurückübersetzt [17] und anschließend wurden die ursprüngliche und die rückübersetzte Version miteinander verglichen. Eine einfache Rückübersetzung kann jedoch nicht alle Übersetzungsprobleme beseitigen, daher werden mittlerweile mehrstufige Übersetzungsprozesse empfohlen [17]. Beispielsweise wird gemäß den Richtlinien des European Social Survey Programme zur Übersetzung von Fragebögen unter dem Akronym TRAPD ein fünfstufiger Übersetzungsprozess vorgeschlagen: Translation, Review, Adjudication (deciding on a version), Pre-testing und Documentation [18]. Diese Schritte sollten von Beginn an in Teamarbeit erfolgen. Auch bei der Übersetzung eines Tests ist eine vollständige statistische Überprüfung der übersetzten Version erforderlich.

6. Fazit

Die Konstruktion von Tests bzw. Fragebögen setzt ein gut definiertes Konstrukt oder zumindest einen konkret beschriebenen Konstruktraum voraus. Auf dieser Grundlage können Items formuliert werden, die inhaltlich valide und gut verständlich sein müssen und sich an den Zielen des Verfahrens orientieren. Hat sich das Verfahren in Vortests an kleinen Personengruppen bewährt, können seine strukturellen (Dimensionalität) und weiteren psychometrischen (Reliabilität, Validität etc.) Eigenschaften anhand von umfangreicheren Datenerhebungen überprüft werden. Um die Validität der Testergebnisse zu bestimmen, müssen verschiedene Aspekte berücksichtigt werden. Diese beziehen sich vor allem auf das zu messende Konstrukt und seine theoretische Einbettung sowie seine Beziehung zu anderen Variablen, aber auch auf den Kontext der Messung und die Konsequenzen, die aus den Testergebnissen abgeleitet werden.

ORCIDs der Autorin und des Autors

- Marianne Giesler: [0000-0001-9384-2343]

- Götz Fabry: [0000-0002-5393-606X]

Interessenkonflikt

Die Autorin und der Autor erklären, dass sie keinen Interessenkonflikt im Zusammenhang mit diesem Artikel haben.

Literatur

[1] Mummendey HD, Grau I. Die Fragebogen-Methode. 5. Aufl. Göttingen: Hogrefe Verlag; 2008.[2] Bühner M. Einführung in die Test- und Fragebogenkonstruktion. 3. aktual. u. erw. Aufl. München: Pearson Studium; 2011.

[3] Brähler E, Holling H, Leutner D, Petermann F. Brickencamp Handbuch psychologischer und pädagogischer Tests. 3. Aufl. Göttingen: Hogrefe; 2002.

[4] Rost J. Was ist aus dem Rasch-Modell geworden? Psych Rundsch. 1999;50(3):140-156. DOI: 10.1026//0033-3042.50.3.140

[5] Döring N, Bortz J. Forschungsmethoden und Evaluation in den Sozial- und Humanwissenschaften. 5. vollst. überarb., aktual. u. erw. Aufl. Berlin: Springer; 2016. DOI: 10.1007/978-3-642-41089-5

[6] King LA, Walker LM, Broyles SJ. Creativity and the five-factor model. J Res Pers. 1996;30(2):189-203.

[7] Reinders H. Fragebogen. In: Reinders H, Ditton H, Gräsel C, Gniewosz B, editors. Empirische Bildungsforschung. Strukturen und Methoden. Wiesbaden: VS Verlag für Sozialwissenschaften; 2011. p.53-65. DOI: 10.1007/978-3-531-93015-2_4

[8] Porst R. Im Vorfeld der Befragung: Planung, Fragebogenentwicklung, Pretesting. ZUMA-Arbeitsbericht, 1998/02. Mannheim: Zentrum für Methoden und Analysen (ZUMA); 1998. URN: urn:nbn:de:0168-ssoar-200484

[9] Loevinger J. Objective tests as instruments of psychological theory. Psychol Rep. 1957;3(3):635-694. DOI: 10.2466/pr0.1957.3.3.635

[10] Lienert GA. Testaufbau und Testanalyse. 2. durchges. u. verb. Aufl. Weinheim: Beltz; 1961.

[11] MacCallum RC, Widaman KF, Zhang S, Hong S. Sample Size in Factor Analysis. Psychol Method. 1999;4(1):84-99. DOI: 10.1037/1082-989X.4.1.84

[12] Repke L, Birkenmaier L, Lechner CM. Validity in Survey Research - From Research Design to Measurement Instruments. Mannheim: GESIS – Leibniz-Institute for the Social Sciences (GESIS – Survey Guidelines); 2024. DOI: 10.15465/gesis-sg_en_048

[13] Messick S. Validity of Psychological Assessment. Validation of Inferences from Persons’ responses and performances as scientific inquiry into score meaning. Am Psychol. 1995;50(9):741-749. DOI: 10.1002/j.2333-8504.1994.tb01618.x

[14] Campbell DT, Fiske DW. Convergent and discriminant validation by the multitrait-multimethod matrix. Psychol Bull. 1959;56(2):81-105.

[15] AERA, APA, NCME. Standards for Educational and Psychological Testing. Washington: American Psychological Association (APA); 2014.

[16] Schaper N. Validitätsaspekte von Kompetenzmodellen und -tests für hochschulische Kompetenzdomänen. In: Musekamp F, Spöttl G, editors. Kompetenz im Studium und in der Arbeitswelt. Nationale und internationale Ansätze zur Erfassung von Ingenieurkompetenzen. Frankfurt, M: Lang; 2014. p.21-48.

[17] Su CT, Parham LD. Generating a valid questionnaire translation for cross-cultural use. Am J Occup Ther. 2002;56(5):581-585. DOI: 10.5014/ajot.56.5.581

[18] European Social Survey. ESS Round 11 Translation Guidelines. London: ESS ERIC Headquarters; 2022. Zugänglich unter/available from: https://www.europeansocialsurvey.org/sites/default/files/2024-08/ESS_R11_Translation_Guidelines.pdf

[19] Moosbrugger H, Kelava A. Qualitätsanforderungen an einen psychologischen Test (Testgütekriterien). In: Moosbrugger H, Kelava A, editors. Testtheorie und Fragebogenkonstruktion. 3. vollst. neu bearb., erw. u. akt. Aufl. Heidelberg: Springer; 2020. p.7-26. DOI: 10.1007/978-3-540-71635-8_2

[20] Downing SM. Validity: on meaningful interpretation of assessment data. Med Educ. 2003;37(9):830-837. DOI: 10.1046/j.1365-2923.2003.01594.x